Что представляют собой трансформаторы тока CTB 25. Для чего они предназначены. Какие у них основные технические характеристики. Как устроены трансформаторы CTB 25. Где они применяются. Каковы их преимущества.

Назначение и область применения трансформаторов тока CTB 25

Трансформаторы тока CTB 25 предназначены для измерений и защиты электрооборудования в распределительных устройствах высокого напряжения закрытого типа с номинальным напряжением до 25 кВ. Они относятся к категории проходных трансформаторов тока.

Основные области применения CTB 25:

- Измерение тока в высоковольтных цепях

- Питание измерительных приборов и устройств релейной защиты

- Организация учета электроэнергии

- Контроль параметров электрической сети

Данные трансформаторы устанавливаются в закрытых распределительных устройствах электрических подстанций, а также в комплектных распределительных устройствах.

Ключевые технические характеристики CTB 25

Трансформаторы тока CTB 25 имеют следующие основные параметры:

- Номинальное напряжение: до 25 кВ

- Номинальный вторичный ток: 5 А или 1 А

- Классы точности измерительных обмоток: 0,2; 0,5; 0,2S; 0,5S; 1; 3

- Классы точности защитных обмоток: 5P; 10P; PX

- Номинальная нагрузка: от 2,5 до 60 ВА

- Максимальный рабочий ток: 120% от номинального (по согласованию до 200%)

Трансформаторы соответствуют заявленному классу точности в диапазоне 25-100% номинальной нагрузки. Это обеспечивает высокую точность измерений в широком диапазоне токов.

Особенности конструкции трансформаторов CTB 25

Конструктивно трансформаторы CTB 25 выполнены как вводные трансформаторы. Их особенности:

- Первичная обмотка состоит из одного или двух витков

- Вторичные обмотки намотаны на тороидальные магнитопроводы

- Активная часть залита эпоксидным компаундом

- Клеммы первичной обмотки оснащены болтами

- Возможна установка до 3-х сердечников

- Предусмотрено переключение диапазонов первичного тока на вторичной стороне

Такая конструкция обеспечивает высокую надежность, точность измерений и удобство монтажа трансформаторов.

Как выбрать оптимальный трансформатор тока CTB 25?

При выборе трансформатора CTB 25 необходимо учитывать следующие факторы:

- Номинальное напряжение сети

- Требуемый номинальный первичный ток

- Необходимый класс точности

- Номинальную вторичную нагрузку

- Количество вторичных обмоток

Важно правильно рассчитать ожидаемую нагрузку трансформатора, чтобы обеспечить его работу в нормированном классе точности. Рекомендуется выбирать трансформатор с некоторым запасом по номинальному первичному току.

Монтаж и эксплуатация трансформаторов CTB 25

При установке и использовании трансформаторов CTB 25 следует соблюдать ряд правил:

- Монтажное положение может быть любым

- Крепление осуществляется четырьмя болтами М12

- Для подключения вторичных цепей рекомендуется использовать кабельные наконечники

- Необходимо заземлять вторичные обмотки

- Запрещена эксплуатация с разомкнутой вторичной цепью

- Требуется периодическая поверка трансформаторов

При соблюдении правил эксплуатации трансформаторы CTB 25 обеспечивают длительную и надежную работу.

Преимущества трансформаторов тока CTB 25

Трансформаторы CTB 25 имеют ряд важных достоинств:

- Высокая точность измерений

- Широкий диапазон первичных токов

- Компактные размеры

- Удобство монтажа и обслуживания

- Возможность переключения диапазонов

- Высокая надежность

- Длительный срок службы

Эти преимущества делают трансформаторы CTB 25 оптимальным выбором для применения в современных распределительных устройствах.

Нормативные требования и сертификация

Трансформаторы тока CTB 25 соответствуют требованиям следующих стандартов:

- IEC 61869-1 «Трансформаторы измерительные. Часть 1. Общие требования»

- IEC 61869-2 «Трансформаторы измерительные. Часть 2. Дополнительные требования для трансформаторов тока»

Производитель по запросу предоставляет официальное подтверждение результатов испытаний трансформаторов. Это гарантирует соответствие заявленным характеристикам и требованиям нормативных документов.

Заключение: эффективное решение для измерения тока

Трансформаторы тока CTB 25 представляют собой современное и надежное решение для измерения тока в распределительных устройствах высокого напряжения. Их основные преимущества:

- Широкий диапазон первичных токов и классов точности

- Компактная и удобная конструкция

- Высокая точность измерений

- Соответствие международным стандартам

Благодаря этим качествам трансформаторы CTB 25 находят широкое применение в энергетике и промышленности для организации учета электроэнергии и защиты оборудования. При правильном выборе и эксплуатации они обеспечивают длительную и надежную работу в составе распределительных устройств.

НАШІ ГРОШІ – Жити по-григоріанськи

Жити по-григоріанськи 16.07.2015 // 928 ПереглядівЧим трансформатори від Григоришина часів Порошенка відрізняються від вишок Бойка часів Януковича.

Чого не люблять робити в «Наших грошах» – так це говорити неприємні речі жінкам. Особливо, якщо вони – депутати. Але життя – річ жорстка, відтак ми приречені засмутити народного депутата Вікторію Войцицьку, яка кілька днів тому висловила надію, що майбутній тендер, який заточений під наближеного до Порошенка олігарха Григоришина, пройде без корупції і за участю світових компаній.

Надія, як то кажуть вмирає останньою, але все-таки вмирає. При чому стається це просто зараз. Бо саме сьогодні, о 10.00 в одному з кабінетів по вул. Лумумби, 97 у Артемівську хтось відкриє кілька конвертів і згідно з усіма законами психології відразу отримає внутрішнє переконання – півмільярда гривень має отримати саме ця фірма. Уже по тому будуть засідання і протоколи, які закріплять у гранітній букві закону вже прийняте внутрішнє рішення: оновлена держава розпочала одну з найбільших оборудок у постмайданній історії України. І серед українських мемів поряд з «вишками Бойка» з’являться і «трансформатори Григоришина».

Ми звісно не стверджуємо, що обидві ці схеми – це однакові краплі води. Є й відмінності. Але почнемо все-таки з подібностей.

Схеми і громадськістьКупівлі вишок передував легкий патріотичний піар: енергонезалежність, розвиток українських надр і т.д. Проблеми з’явились лише тоді, коли виникло питання ціни.

Із трансформаторами все трохи інакше. Про корупцію тут заговорили практично на самому початку. Спершу «Главком», згодом «Інсайдер», а ще ціла низка народних депутатів просто-таки волали про те, що на очах у публіки хочуть розпиляти сотні мільйонів, якщо не мільярдів.

У двох словах нагадаємо суть: держава вирішила потратити 4 млрд грн. на трансформатори, які в Україні виробляє лише завод «Запоріжтрансформатор» Костянтина Григоришина. І зробити все, щоб більше на тендер ніхто не потрапив. Ціна передбачалась – вдвічі завищеною від ринкової. Тобто 2 млрд грн. мали потекти в правильні кишені.

Для офіційного старту схеми бракувало тільки того, щоб Нацкомісія з енергетики затвердила нову інвестпрограму для «Укренерго».

Незважаючи на ґвалт і звинувачення в корупції, Нацкомісія затвердила програму. Єдине, що змінилось: сума. Вона сповзла до 2,1 млрд грн.

Цей сегмент історії є важливим тому, що, здається, вперше в історії постмайданної України тіньова схема запустилась, не зважаючи на те, що всі навколо тільки й говорили, що вона – тіньова.

Це дуже нагадало часи Януковича, коли після купівлі першої вишки і шуму в газетах люди Бойка придбали другу. Так само через підставні фірми і з такою самою маржею.

Схеми і потреба в товаріТут є відмінність. При чому, як не парадоксально – на користь команди Бойка. Бурові установки «Чорноморнафтогазу» були справді потрібною штукою: вони дійсно робили в морському дні дірки, на які не були здатні вишки радянського періоду.

Трансформатори натомість купуються «аби було». Експерти ринку вже неодноразово наголошували, що в Україні міняють щороку від одного до п’яти трансформаторів, а не 37, як передбачалось спочатку, і не 27, на чому врешті зійшлися.

У своєму емоційному пості в ФБ народний депутат Олексій Скрипник так описав цю ситуацію:

«(потрібна) добудова підстанції 750кВ Київська з двома заходами 330 кВ… Ще є 5-6 дуже потрібних для заміни автотрансформаторів. І все! Чому не потрібні інші? Бо трансформатор це не мотор, – якщо він працює – то він працює. А з врахуванням того, що в нас з 1991 року навантаження знижується, то більшість трансформаторів є недозавантажена (напевно за виключенням Києва). І в них нема обмежень по часовому ресурсу(в Житомирі працюють ще довоєнні), але чи це чесно міняти, коли воно працює і коли ми не маємо грошей на сучасне озброєння?»

Підписався Скрипник, до речі, так: “Народний депутат, інженер-електрик, 14 років стажу в диспетчерській службі Західної енергосистеми”.

Не допомогло. Бо жадібність – це почуття сильніше, ніж сором. Змагатись в емоційному плані із жадібністю може тільки страх.

А те, що страху тут нема – свідчить аналіз цін.

Схеми і переплатиВишки Бойка при ціні в 250 млн доларів коштували бюджетові 400. А ще відняти витрати на транспортування. На фоні трансформаторів Григоришина – це просто дитячий садок.

Ми ознайомились із цінами різних виробників, які ходять по ринку і, які є вдвічі меншими планованих витрат від «Укрнерго». Коли виробники нам підтвердять ці цифри офіційно, обов’язково оприлюднимо їх для широкого загалу. Але навіть того, що є вже зараз вистачає, аби зрозуміти: «вишківська» переплата – це просто нікчемність на фоні «трансформаторної».

Нагадаємо, що оскільки трансформатори є занадто різної потужності, то мірилом їхньої ціни є дріб $/мегавольт-ампер.

«Інсайдер» у своєму дослідженні опублікував ціни в Росії. У 2013 році – це $12 тис за МВА, у 2014 – $15 тис.

Так виглядає, що це однак теж зависокі ціни. Особливо, якщо зважати на санкції, а відтак і обмежену кількість товару на ринку. Тим паче у всьому світі ціни будуть тільки знижуватись. Оскільки дешевшають основні матеріали, з яких роблять трансформатори – сталь та мідь.

Саме тому на світовому ринку є маса пропозицій з цінами 10-13 тис. $/МВА. Мало того, такі ціни є навіть в Україні, і навіть у Григоришина. Правда, не для українців.

Скажімо, у вересні 2014 року «Запоріжтрансформатор» поставив білоруському «Мінскенерго» трансформатор АТДТН-200000/330/110-У1 (у розпорядженні «Наших Грошей» є дані про заводське замовлення). Запоріжці задекларували вартість трансформатора у розмірі 26,31 млн грн., що з урахуванням тодішнього курсу 12,8 грн./долар дає вартість трансформатора 10,3 тис. $/МВА.

Натомість саме такий трансформатор хотіла у червні придбати Північна електроенергетична система ДП «НЕК «Укренерго». Його мав вигравати «Запоріжтрансформатор» з ціною 81,38 млн грн., що по курсу становило вже 19 тис. $/МВА Однак тендер відмінили, про що трохи згодом.

Ця ціна є аномальною. Навіть для Росії, яка славиться своїм рівнем корупції. Покопавшись у російському аналогу «Вісника держзакупівель», ми знайшли, що, наприклад, «Сетевая компания» (Казань) у травні цього року придбала трансформатор АТДЦТН-200000/220/110 У1 за 130 млн рублів, що дає питому ціну 12 тис $/МВА.

В Україні усе набагато крутіше. Подібний трансформатор весною планувала придбати Дніпровська електроенергетична система «Укренерго». По $25 тис. Тоді «Запоріжтрансформатор» прийшов на тендер з надзвичайно «економною» пропозицією в $22 тис.

Що ж до вже оголошених нових тендерів, то передбачається закупівля Південно-Західної системи «Укренерго» на придбання трансформатора з очікуваною ціною 113 млн грн., або $26 тис $/МВА.

Приблизно такі ж цифри маємо очікувати на тендерах Південно-Західної електроенергетичної системи «Укренерго». В Вінниці 7 серпня планують розіграти 205 млн грн. на два трансформатори: АТДТН-125000/330/110/35кВ – по $33 тис, АТДТН-200000/330/110-У1 – по $26 тис.

Звісно, фактична тендерна ціна може відрізнятись від очікуваної. Однак практика українських закупівель свідчить, що учасники тендеру в курсі, скільки планує витратити замовник, тому зазвичай остаточна ціна виявляється не набагато нижчою від планової. Тим більш, коли планову завищують у два рази, то скинути з неї кілька відсотків – не проблема.

Звідки взялись ці гігантські очікувані цифри? Очільники Нацкомісії відповіли Вікторії Войцицькій, що «Укренерго» сформувало свої очікувані ціни на підставі довідки від Торгово-промислової палати.

Тут знову війнуло минулим. Бо саме на довідці від Торгово-промислової палати будував свій захист «Нафтогаз» по афері з «вишками Бойка». Тоді доброзичливі «торгові промисловці» надали довідку, що ціна на такі бурові вишки на світових ринках коливається у діапазоні $355-410 млн. Замість $200-250 млн, як то було насправді.

Ми розуміємо, що читачу дещо зносить мозок наш перелік тендерів, які вже пройшли і які будуть проходити. Бо логічно пояснити, як могли проходити тендери без затвердження інвестпрограми – складно, якщо взагалі можливо. Адже саме інвестпрограма показує, звідки на все це свято беруться гроші.

Але саме у цьому і криється фішка. Усе це зроблено для того, аби на наш вітчизняний і заздалегідь розписаний тендер не потикались іноземці, які нам, звичайно, друзі, але не в такій тонкій сфері, як особисті фінанси.

Чому іноземців не буде?Насправді тендери на 2 млрд грн. на закупівлю трансформаторів «Укренерго» почало ще весною. Одразу по призначенню головою держкомпанії Юрія Касіча, що працював у «Луганському енергетичному обєднанні», Вінницькому та Черкаському обленерго Григоришина. Без інвестпрограми, без чіткого розуміння, звідки прийдуть гроші. Провели – і все.

Іноземних компаній з їхніми смішними цінами в $10-13 тис. не було. І цілком зрозуміло чому: іноземці не можуть дозволити собі вв’язуватись в незаконну аферу, навіть якщо там пахне прибутком. Не говорячи вже про те, що навіть якщо б якомусь «Сіменсу» вдалося би магічним чином перемогти на тендері, то згодом він міг просто не побачити жодних грошей.

Єдині, хто не збентежився цією пікантною ситуацією – виявились представники Росії. Тобто тієї країни, звідки й приїхав до України той самий Григоришин.

Тендери навіть дійшли до розкриття пропозицій, які у всіх випадках були від двох заводів – григоришинського «Запоріжтрансформатора» і «Энергомаш (Єкатеринбург) – Уралэлектротяжмаш».

Запоріжці і уральці подавали заявки з різницею у кілька відсотків, що дуже дивно. Оскільки мова йде не про чіпси, які робляться у різних частинах світу за однією технологією.

Ось такі та ще більші трансформатори григоришинського заводу хоче купити “Укренерго” на 2 млрд грн. Тендерна вартість одного – близько 100 млн грн.

У григоришинців і росіян, виявляється, так співпадали кошториси, що «Уралэлектротяжмаш» пропонував своє обладнання дорожче лише на кілька відсотків. Лише на один тендер подала свою заявку компанія «СвердловЕлектро-Україна» ( місцевий представник іншого російського заводу), який пропонував трансформатор дешевше. Але суворий тендерний комітет відхилив цю дешеву пропозицію, бо у неї і тип охолодження був не той, і рівень шуму від трансформатору невідомий, і аванс хотіли завеликий, і взагалі не надали свою антикорупційну програму.

Тобто все йшло до того, що 2 млрд грн. не дуже по закону, але згідно до довідки Торгово-промислової палати розійдуться по правильним кишеням.

Але тут сталась одна халепа. Як не дивно – із Антимонопольним комітетом. Її ми опишемо в наступному розділі, а зараз закінчимо з іноземцями.

Здавалось би, що після того, як Нацкомісія затвердила інвестпрограму, усі ці Сіменси, Хундаї, АВВ і т.д. відкрили собі дорогу до жирних українських тендерів. На жаль, – ні.

Технологія підготовки тендерної документації є муторною справою, особливо якщо передбачається велика сума. А, нагадаємо, багато тендерів уже не тільки оголошені, а й вже закінчуються. Як півмільярдний сьогоднішній тендер в Артемівську, про який ішлося на початку тексту. До речі, очікувана вартість трансформаторів тут зашита на рівні $27 тис.

Подарунок від АМКУОтже коли вже все було готово для списування грошей (переможцю тендеру передбачено 50% аванс, що в принципі повністю покриває ринкову ціну трансформаторів), у спину «Запоріжтрансформатору» прилетів зрадницький вирок з АМКУ. Там нещодавно отримали нового голову Юрія Терентьєва і на радощах почали чистити авгієві конюшні тендерних змов за роки Януковича. У тому числі АМКУ затвердив січневий вирок свого запорізького відділення щодо змови «Запоріжтрансформатора» і «Запорізького заводу надпотужних трансформаторів» (фактично це фрагмент першого заводу), які у 2011 – 2013 роках розіграли шість тендерів підконтрольних Григоришину обленерго на поставку трансформаторів на сотні мільйонів гривень по захмарним цінам. Наприклад, «Чернігівобленерго» купувало по 29 тис. $/МВА.

Звісно, за «кривавого режиму» АМКУ не дуже переймався цими історіями. Але після Майдану взявсь. Ну і поволі довів до розуму звинувачення щодо змови між двома заводами Григоришина, у яких були однакові акціонери і абсолютно однаково намальовані тендерні заявки.

Штраф за розпил десятків мільйонів просто смішний – 300 тис грн. Але біда в тому, що за нинішнім законодавством учасників тендерної змови заносять у «чорний список» і на три роки забороняють участь у тендерах. Тобто коли «Укренерго» мало акцептувати 2-мільярдні угоди з «Запоріжтрансформатором» абсолютно інше відомство забороняло цьому заводу брати участь у тендерах взагалі!

Так виглядає, що саме цей недогляд юридичної служби Григоришина зіпсував виграну партію.

Бо тепер треба було обирати – або через суд відміняти вирок АМКУ, або проводити тендери заново.

Наскільки ми розуміємо, здебільшого було обрано лінію на нові тендери. Продовжено донецький, про який ми говорили на початку статті, оголошено два нові у Вінниці – загалом на 700 млн грн. Ще по половині торгів (у грошовому виразі) рішення про відміни поки що немає. А по тендерам приблизно на 400 мільйонів гривень конкурсні комітети «Укренерго» знайшли проблеми у заявках і «Запоріжтрансформатора», і його російського спаринг-партнера. Порушення – дуже «серйозні». Наприклад, «Запоріжтрансформатор» викинули у тому числі за те, що «термін дії посвідчення з електробезпеки на Сидорцова О.І. закінчився 18.03.14 р.»! А «Уралэлектротяжмаш» посмів не заповнити графу «Освіта із зазначенням учбового закладу, кваліфікація по диплому» у переліку працівників відповідної кваліфікації!

Усе-таки вміють відміняти тендери наші замовники, якщо прийшла команда це зробити. Бажаючі можуть насолодитись раптовим прозрінням тендерного комітету (весь перелік причин для відмови – 15033WX300148-1). А ми перейдемо до наступної частини.

Перший трансформатор – гуманітарний конвойНардеп Олексій Скрипник вважає, що найбільше Україна потребує трансформатора у Києві. Цитуємо:

«Особливо це стосується, добудови підстанції 750кВ Київська з двома заходами 330 кВ. для живлення Києва, що стало вкрай необхідним після виведення з роботи Чорнобильської електростанції. Якщо ми не добудуємо цю підстанцію і лінії, то кредит виділений на побудову лінії 750 кВ буде неефективний, так як лінія закінчиться в пустоту».

Підстанція “Донбаська” (обведена зеленим) є останньою ланкою у транзитній енергомережі між Заходом і Сходом України – саме “Донбаська” є ключовим пунктом по забезпеченню взаємодії мереж України та ДНР.

«Укренерго» так не вважає. На сьогоднішньому тендері планують придбати за 500 млн грн. два автотрансформатори АОДЦТН-417000/750/500/15,75-У1 та три шунтуючі реактори 750 кВ для встановлення на підстанції «Донбаська» у селі Весела Долина під Артемівськом. Не плутайте це з Веселою Долиною під Дебальцево, яку Кабмін у травні визнав непідконтрольною Україні. Але й не занадто радійте. Бо наша Весела Долина розташована у так званій «зоні безпеки» збройних сил України. І лише кілька тижнів тому саме поряд з Веселою Долиною відбувся бій з диверсійно-розвідувальною групою терористів ДНР (на карті позначено хрестом).

Ми, звичайно, розуміємо, що Петро Порошенко є прихильником Мінських угод і повернення ДНР-ЛНР в лоно України. А для цього у тому числі потрібно забезпечити «старих-нових» громадян безперебійним електроживленням.

Але за бізнес-логікою усе-таки варто купувати речі туди, де вони найбільше потрібні, а не туди, де найбільше хочеться.

Говоримо – Порошенко, бо саме його люди зараз причетні до трансформаторної історії.

Петро Порошенко

Дмитро Вовк

Саме Порошенко зробив керівником НКРЕКП Дмитра Вовка, який раніше працював у «Рошені» та інвесткомпанії ICU Валерії Гонтарєвої, що обслуговувала інтереси Порошенка і Григоришина.

Саме в ICU працював і міністр енергетики Демчишин, який призначив керівником «Укренерго» Юрія Касіча, екс-менеджера Григоришина.

Юрій Касіч

І саме Нацкомісія Вовка затвердила пропозицію григоришинського менеджера з «Укренерго» витратити 2 мільярди гривень на закупівлю трансформаторів, які в Україні виробляє тільки завод Григоришина.

Костянтин Григоришин

Коротше, апелювати нема до кого. Бо чия прокуратура – теж всі знають. Нам залишається лише дочекатись закінчення тендерів, потім порахувати маржу. І врешті визначити переможця – «трансформатори Григоришина» чи «вишки Бойка». Поки що упевнено лідирує перше команда.

Юрій Ніколов, Олексій Шалайський, «Наші Гроші»

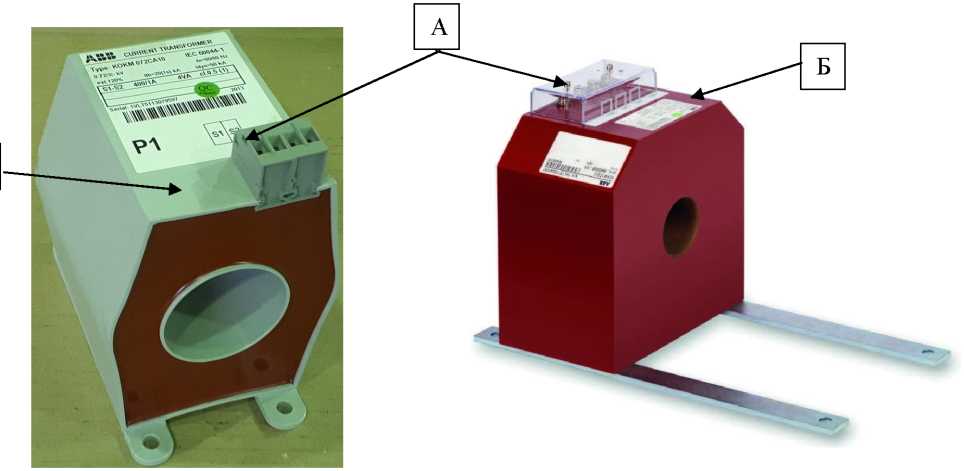

Проходной трансформатор тока CTB 25

Аппаратные трансформаторы тока CTВ 25 предназначены для измерений и защиты оборудования распределительных устройств ВН закрытого исполнения с напряжением до 25 кВ.

Значение вторичного тока составляет 5 А или 1 А с возможностью комбинирования. Классы точности измерительных цепей: 0,2; 0,5; 0,2S; 0,5S; 1; 3; цепей защиты: 5Р; 10Р; PX. Трансформаторы соответствуют требуемому классу точности в интервале 25 – 100% номинальной нагрузки. Максимальный рабочий ток составляет 120% IN, по согласованию с заказчиком можно поставить аппараты и с другими величинами, например, 200% IN.

Трансформаторы СТВ 25 решены как трансформаторы вводные, у которых первичный проводник образует один или два витка, в соответствии с требуемыми параметрами. Клеммы первичной обмотки трансформатора оснащены болтами. Для присоединения входящих шин в направлении продольной оси устройства могут поставляться специальные петушки с отверстиями диаметром 14 мм или палец с эпоксидной надставкой (см. эскиз с размерами).

Вторичная обмотка намотана на магнитный сердечник из ориентированных пластин, изготовленных из магнитного материала, или сплава никеля, железа и меди “permalloy“. Количество сердечников – от 1 до 3, в соответствии с требованием заказчика и согласно запрашиваемых параметров. Конструкция трансформатора позволяет производить переключение диапазонов первичного тока на вторичной стороне. Все активные части трансформатора залиты эпоксидной смесью. Эта масса выполняет как электроизоляционную, так и механическую функции.

Монтажное положение трансформаторов может быть любое. Трансформаторы закрепляются с помощью четырех болтов М12 через отверстия в опорной плите. Для присоединения к выводам на вторичной обмотке рекомендуется использовать кабельные наконечники, соответствующие сечению проводника.

Клеммник вторичной обмотки оснащен кожухом с винтом для опломбирования. Внутри находится упаковка с перемычками и винтами для заземления и закорачивания обмотки (см. “Руководство по монтажу и обслуживанию”).

Трансформаторы CTB 25 прошли испытания в соответствии с нормой IEC 61869-1, IEC 61869-2.

По желанию заказчика обеспечиваем официальное подтверждение результатов испытаний.

Другие технические характеристики можно проконсультировать с производителем.

Трансформатор ТМН

По заказу возможно изготовление и поставка трехобмоточных трансформаторов (ТМТН, ТДТН), имеющих три группы выводов: ВН напряжением 110 кВ, СН на 6-10 кВ, НН на 0,4 кВ.

9.12. Корректированные уровни звуковой мощности трансформаторов с пониженным уровнем шума

| Типовая мощность трансформатора, кВА |

Корректированный уровень звуковой мощности, LPA, дБА 6-110 кВ |

| 1000 | 65 |

| 1600 | 67 |

| 2500 | 68 |

| 4000 | 71 |

| 6300 | 73 |

| 10000 | 76 |

| 16000 | 80 |

| 25000 | 81 |

Основные технические характеристики

| Тип трансформатора |

ТМН, ТМНС, ТДН, ТДНС, ТРДН, ТРДНС |

|

Мощность |

1000 — 25 000 кВА |

|

Группа соединения обмоток | Y/D-11, D/D-0, D/Yn-11, Y/Yn-0 |

|

Материал обмоток ВН и НН |

алюминий/медь |

|

Номинальное высшее напряжение |

10,5 — 110 кВ |

|

Номинальное низшее напряжение |

690 В, 6 кВ, 10 кВ |

|

Количество ступеней регулирования напряжения |

± 8 х 1,5% ± 8 х 1,25% ± 6 х 1,5% ± 4 х 2,5% |

|

Номинальное значение климатических факторов |

У1, УХЛ1 по ГОСТ 15150 и ГОСТ 15543.1 |

|

Охлаждение |

AN (естественное) — до 10 000 кВА AF (принудительное) — от 10 000 кВА |

| Температура эксплуатации, транспортировки и хранения |

— 45 … + 40 °С для У1 — 60 … + 40 °С для УХЛ1 |

|

Срок службы |

30 лет |

|

Гарантийный срок |

до 5 лет |

|

Стандарт |

ГОСТ Р 52719-2007, ГОСТ 11920-85, ГОСТ 1516.3-96 |

|

Специальное исполнение |

по заказу клиента |

Конструктивные особенности

Магнитный сердечник изготавливается из высококачественной электротехнической стали марки Э3409, Э3410, Э3411 (тонколистовой холоднокатаной анизотропной стали с двухсторонним покрытием). Шихтовка магнитопровода осуществляется по технологии step-lap, что обеспечивает малые потери холостого хода и приводит к снижению уровня шума.

Обмотки ВН — многослойные или непрерывные, в зависимости от мощности и параметров трансформатора. Изготавливаются из медного или алюминиевого провода в бумажной изоляции.

Обмотки НН производятся из алюминиевой/ медной ленты (до 4000 кВА) с межслойной изоляцией из кабельной бумаги или из медного провода (более 4000 кВА).

Бак – цельносварной, усиленной конструкции, производится из стального листа толщиной 4-12 мм для трансформаторов до 10 000 кВА и 12-20 мм — свыше 10 000 кВА. Конструкция баков представляет собой жесткий каркас, усиленный ребрами жесткости.

На крышке трансформатора расположены выводы ВН и НН, расширитель, устройство РПН, газовое реле, серьги для подъема и перемещения трансформатора, гильза для установки спиртового термометра, патрубок для заливки трансформаторного масла с установленным в него предохранительным клапаном. К торцевой части баков ТМН и ТДН крепится шкаф управления устройством РПН. В нижней части бака имеется пробка или кран для отбора пробы и слива масла, а также пластины заземления, расположенные с двух сторон. К дну бака приварены лапы (опоры) из стандартного швеллера.

На стенках бака имеются фланцы с кранами для присоединения съемных радиаторов, которые служат для охлаждения трансформатора. Радиаторы – панельные, толщина стенки 2 мм.

Наружная поверхность бака окрашена атмосферостойкими красками серых тонов (возможно изменение окраски по требованию заказчика). По заказу клиента возможна обработка баков и крышки методом горячего цинкования, что позволит использовать трансформатор в зоне с влажным климатом.

Расширители трансформатора снабжены двумя указателями уровня масла. По заказу потребителей трансформаторы могут изготавливаться с указателем нижнего предельного уровня масла и включать в себя датчики уровня.

Для трансформаторов климатического исполнения УХЛ1 используется масло, стойкое к низким температурам — имеющее температуру гелеобразования – 65 ˚С.

Условия эксплуатации

Эксплуатация трансформатора осуществляется согласно руководству по эксплуатации завода-изготовителя, действующим «Правилам технической эксплуатации», «Правилам устройства электроустановок».

Климатическое исполнение и категория размещения трансформаторов У1 или УХЛ1 — по ГОСТ 15150, при этом:

— окружающая среда не взрывоопасная, не содержащая токопроводящей пыли;

— высота установки над уровнем моря не более 1000 м;

— режим работы длительный;

— трансформаторы в стандартном исполнении не предназначены для работы в условиях химически активных сред.

Требования по эксплуатации

Трансформаторы марки «Трансформер» рассчитаны на продолжительную работу при повышениях напряжения, подводимого к любому ответвлению обмотки ВН, над номинальным напряжением данного ответвления но не более 10%. При этом мощность не должна превышать номинальную.

Комплектация

В обязательную комплектацию трансформаторов ТМН марки «Трансформер» входят:

- расширитель с указателем уровня масла,

- предохранительная труба или предохранительный клапан,

- катки или поворотные каретки,

- радиаторы; для трансформаторов ТДН – радиаторы с вентиляторами,

- шкаф автоматического управления системой охлаждения (для трансформаторов с системой охлаждения Д),

- встроенные трансформаторы тока,

- коробка зажимов для присоединения контрольных и силовых кабелей,

- газовое реле для защиты трансформатора,

- манометрические сигнализирующие термометры с круговой шкалой,

- вводы,

- устройство РПН комплектно с аппаратурой автоматического регулирования,

- воздухосушитель,

- клеммная коробка – для трансформаторов с установленными электроконтактными мановакуумметрами и термометрами с электрическими контактами.

В дополнительной комплектации (опция) — мановакуумметры с переставными сигнальными контактами, комплект запасных частей и необходимого специального инструмента.

Упаковка и транспортировка

Трансформаторы отгружаются без упаковки, при этом выводы ВН и НН защищаются от повреждений при транспортировке. По требованию заказчика изделия могут упаковываться в транспортную тару – ящики. Способ упаковки согласовывается с заказчиком

Трансформатор перевозится в частично разобранном виде (без радиаторов и расширителя), высушенными и заполненными трансформаторным маслом. Дополнительно осуществляется поставка масла для доливки в трансформаторы.

Не допускается транспортирование трансформаторов, не раскрепленных относительно транспортных средств. При перевозке изделия не допускается резких торможений и разгонов, излишних вибраций и толчков.

Гарантия

Гарантия производителя — до 5 лет. Срок службы — 30 лет.

Специалисты производственной группы «Трансформер» оказывают содействие в решении вопросов доставки изделий до места установки. Транспортные услуги, а также услуги по диагностике трансформаторов, монтажным и ремонтным работам оговариваются сторонами отдельно.

Трансформатор сухой ТСЗЛ-2500 кВА /6;10/0,4 по низкой цене

Описание

Силовой двух обмоточный трехфазный трансформатор, без жидкого диэлектрика, сухой, с литой изоляцией и естественным воздушным охлаждением класса напряжения 6кВ или 10кВ частотой 50Гц. Трансформатор предназначен для изменения величины напряжения и тока до параметров необходимых потребителю. Используются данные трансформаторы во всех отраслях промышленного и народного хозяйства, где предъявляться особые требования к взрывозащищенности, пожаробезопасности, экологичности .

Трансформаторы ТСЗЛ-защищенного исполнения (степень защить IP21 или IP31. Имеют защитный металлический кожух.

Отличительные особенности данных трансформаторов:

- Меньшие массогабаритные размеры позволяющие, произвести увеличение мощности существующих трансформаторных подстанций при их модернизации без увеличения габаритов,

уменьшить массогабаритные размеры проектируемых трансформаторных подстанций - Максимальная безопасность, устойчив к самовозгоранию и низкий уровень выделения токсичных веществ, минимальное образование дыма.

- Минимальные затраты на эксплуатацию.

- Энергосбережение за счёт сниженных потерь в обмотках и магнитопроводе трансформатора.

- Возможность увеличения коэффициента загрузки трансформатора, за счет принудительной вентиляции обмоток.

| Технические характеристики: | |

| Номинальная мощность | 2500 |

| Номинальное напряжение ВН/НН, кВ | (6;10)/0,4 |

| Схема и группа соединения обмоток | Y/Yн-0

Д/Yн-11 |

| Потери холостого хода, Вт | 4300 |

| Потери короткого замыкания, Вт | 18260 |

| Уровень звукового давления Lpa, дБ | 65 |

| Уровень звуковой мощности Lwa,Дб | 81 |

| Степень защиты | IP21 |

| Класс изоляции | F |

Трансформатор ТВК-10

Трансформатор ТВК-10 – встроенный катушечный измерительный трансформатор тока. Предназначен для уменьшения высоких первичных значений тока до значений пригодных для измерений, вырабатывает сигнал измерительной информации для электроизмерительных приборов, а также цепей релейной защиты и автоматики. Одновременно служит изоляцией вторичных цепей от высокого первичного напряжения, что в свою очередь позволяет сделать работу в электроустановках более безопасной. Трансформатор ТВК-10 предназначен для установки в комплектные распределительные устройства внутренней установки переменного тока, частоты 50, 60 Гц.

Трансформатор ТВК-10 изготавливают в климатическом исполнении “У”, “УХЛ”, или “Т” категории размещения 3 или 2 и его необходимо эксплуатировать при следующих условиях:— установку необходимо производить на высоте не превышающей 1000м над уровнем моря;

— верхнее значение температуры внутри КРУ +45°C, нижнее – до -50°C для исполнения «У», «УХЛ» и от +60°C до -10°C для исполнения «Т»;

— допустимое значение влажности воздуха согласно ГОСТ 155-43.1;

— неагрессивная и не взрывоопасная окружающая среда;

— положение в котором может работать трансформатор – любое.

Чертеж, габаритные и установочные размеры трансформатора ТВК-10

Внимание! При эксплуатации трансформатора, вторичные обмотки должны быть замкнуты!

Основные технические характеристики трансформатора ТВК-10:

| Параметр | Значение |

| Величина номинального напряжения, кВ | 10 |

| Величина наибольшего рабочего напряжения, кВ | 12 |

| Величина номинальной частоты переменного тока, Гц | 50, 60 |

| Величина номинального первичного тока, А | 20; 30; 40; 50; 75; 100; 150; 200; 300; 400; 600; 800; 1000; 1500 |

| Величина номинального вторичного тока, А | 5 |

| Количество вторичных обмоток, шт. | 2 |

| Значение номинальной нагрузки вторичных обмоток, ВА: — для измерений при активно-индуктивном характере нагрузки и cosφ=0,8 — для защиты при активно-индуктивном характере нагрузки и cosφ=0,8 | 10 15 |

| Значение классов точности вторичных обмоток: — для измерений — для защиты | 10P |

| Величина номинальной предельной кратности вторичной обмотки для защиты, не менее | 15 |

| Значение односекундного тока термической стойкости, кА, | 1,88-30 |

| Значение односекундного тока электродинамической стойкости, кА | 7,0-76,5 |

Конструкция трансформатора ТВК-10. Трансформатор ТВК-10 имеет вид опорной конструкции. Это встроенный катушечный трансформатор. Конструкция трансформатора содержит два рядом расположенных прямоугольных шихтованных магнитопровода, первичную и вторичные обмотки. Каждая из вторичных обмоток расположена на своем магнитопроводе. Электрическую прочность изоляции и защиту обмоток от механических воздействий обеспечивает литой блок, созданный благодаря заливке обмоток изоляционным компаундом. В основании трансформатора (на опорной поверхности) имеется четыре отверстия для крепления трансформатора на месте установки. В нижней части литого блока расположены выводы вторичных обмоток.

Вы можете заказать трансформатор ТВК-10 в компании “ЭнергоСфера” позвонив по телефону:

- < Трансформатор ТОЛ-10-IM-2

- Трансформатор ТОЛ-СЭЩ-10-41 >

Трансформатор. Виды трансформаторов.

Назначение трансформатора и его виды. Обозначение на схеме

Трансформатор – один из самых распространённых электротехнических устройств, как в бытовой технике, так и в силовой электронике.

Назначение трансформатора заключается в преобразовании электрического тока одной величины в другую, большую, или меньшую.

В отношении трансформаторов стоит помнить одно простое правило: постоянный ток они не преобразуют! Основное их назначение — это преобразование переменного, импульсного и пульсирующего тока. Если подвести к трансформатору постоянный ток, то получится лишь раскалённый кусок провода…

На принципиальных схемах трансформатор изображают в виде двух или более катушек, между которыми проводят линию. Вот так.

Катушка под номером Ⅰ символизирует первичную обмотку. К ней подводится напряжение, которое необходимо преобразовать: понизить или повысить — смотря что требуется. Со вторичных обмоток (Ⅱ и Ⅲ) уже снимается пониженное или повышенное напряжение. Как видите, вторичных обмоток может быть несколько.

Вертикальная линия между первичной и вторичной обмоткой символизирует магнитный сердечник или по-другому, магнитопровод.

Максимальный коэффициент полезного действия (КПД) трансформатора чрезвычайно высок и в некоторых случаях может быть более 90%. Благодаря малым потерям при преобразовании энергии трансформатор и получил такое широкое применение в электронике.

Основные функции трансформатора, которые более востребованы в бытовой электронике две, это:

-

Понижение переменного напряжения электрической сети 110/127/220В до уровня в несколько десятков или единиц вольт (5 – 48 и более вольт). Связано это с тем, что большинство электронных приборов состоит из полупроводниковых компонентов – транзисторов, микросхем, процессоров, которые прекрасно работают при достаточно низком напряжении питания. Поэтому необходимо понижать напряжение до низких значений. Диапазон напряжения питания такой электроники как магнитолы, музыкальные центры, DVD – плееры, как правило, лежит в пределах 5 – 30 вольт. По этой причине понижающие трансформаторы заняли достойное место в бытовой электронике.

-

Гальваническая развязка электрической сети 220В от питающих цепей электроприборов. Понизить напряжение во многих случаях можно и без использования трансформаторов. Но к этому прибегают достаточно редко. Что самое главное при пользовании электроприбором? Конечно, безопасность!

Гальваническая развязка от электросети снижает риск поражения электрическим током за счёт того, что первичная и вторичная обмотки изолированы друг от друга. При электрическом пробое фазовое напряжение сети не попадёт на вторичную обмотку, а, следовательно, и на весь электроприбор.

Стоит отметить, что, например, автотрансформатор гальванически связан с сетью, так как его первичная и вторичная обмотки соединены между собой конструктивно. Этот момент необходимо учитывать при настройке, отладке и ремонте электронного оборудования, дабы обезопасить себя от поражения электрическим током.

Конструктивно трансформатор состоит из двух и более обмоток – первичной, та, что подключается к сети, и вторичной, которая подключается к нагрузке (электроприбору). Обмотки представляют собой катушки медного или алюминиевого провода в лаковой изоляции. Обе катушки плотно наматываются на изоляционный каркас, который закрепляют на магнитопровод – сердечник. Магнитопровод изготавливают из магнитного материала. Для низкочастотных трансформаторов материалом магнитопровода служит пермаллой, трансформаторная сталь. Для более высокочастотных – феррит.

Магнитопровод низкочастотных трансформаторов состоит из набора Ш, П или Г-образных пластин. Наверняка вы уже видели такие у пунктов приёма цветного металлолома . Магнитопровод из феррита, как правило, цельнотелый, монолитный. Вот так выглядит ферритовый магнитопровод от трансформатора гальванической развязки (ТГР) сварочного инвертора.

У высокочастотных маломощных трансформаторов роль сердечника может выполнять воздушная среда. Дело в том, что с ростом частоты преобразования габариты магнитопровода резко уменьшаются.

Если сравнить трансформатор лампового телевизора с тем, который установлен в современном полупроводниковом, то разница будет ощутима. Трансформатор лампового телевизора весит пару – тройку килограммов, в то время как высокочастотный трансформатор современного телевизора несколько десятков, либо сотен граммов. Выигрыш в габаритах и весе очевиден.

Уменьшение веса и габаритов трансформаторов достигается за счёт применения высокочастотных импульсных преобразователей, где трансформатор работает на частоте в 20 – 40 кГц, а не 50-60 герц, как в случае с обычным низкочастотным трансформатором. Увеличение рабочей частоты позволяет уменьшить размеры магнитопровода (сердечника), а также существенно снизить затраты на обмоточный провод, так как количество витков в обмотках высокочастотных трансформаторов невелико.

По конструктивному исполнению трансформаторы делят на несколько видов: стержневые, броневые и тороидальные (они же кольцевые). Стержневой вариант выглядит вот так.

Броневой же имеет боковые стержни без обмоток. Такая конструкция защищает от повреждений медные обмотки, но и затрудняет их охлаждение в процессе работы. Броневые трансформаторы наиболее распространены в электронике.

Наилучшими параметрами обладают тороидальные, или по-другому, кольцевые трансформаторы.

Их конструкция способствует хорошему охлаждению, а магнитный поток наиболее эффективно распределён вокруг обмоток, что уменьшает магнитный поток рассеяния и увеличивает КПД. Из-за магнитного потока рассеяния возникают потери, что снижает эффективность трансформатора. Наибольший поток рассеяния у броневых трансформаторов.

Мощность трансформатора зависит от размеров сердечника и рабочей частоты преобразования. Во многих случаях мощность низкочастотного трансформатора (работающего на частоте 50-60 Гц) можно определить не прибегая к сложным расчётам. Об этом я уже рассказывал.

Иногда на практике требуется определить выводы первичной и вторичной обмоток. Вот несколько советов, которые помогут разобраться, как это сделать.

Первичная обмотка понижающего трансформатора всегда будет намотана более тонким проводом, чем вторичная. Связано это с тем, что при понижении напряжения возможно увеличение тока во вторичной обмотке, следовательно, нужен провод большего сечения.

В случае повышающего трансформатора вторичная обмотка наматывается более тонким проводом, чем первичная, так как максимальный ток вторичной обмотки будет меньше тока первичной.

В этой взаимосвязи и заключается преобразование: увеличиваем напряжение – уменьшается ток, уменьшаем напряжение – увеличивается ток.

Развитие силовой электроники привело к появлению, так называемых, электронных трансформаторов. Сам по себе электронный трансформатор не является электротехнической деталью — это законченное электронное устройство, которое выполняет функцию преобразования переменного напряжения.

Главная » Радиоэлектроника для начинающих » Текущая страница

Также Вам будет интересно узнать:

Чем отличается трансформатор от автотрансформатора: конструктивно и визуально

Людям, не обладающим широкими познаниями в области электротехники, сложно разобраться в нюансах технического устройства электрических машин. Рассмотрим основные отличия трансформатора от автотрансформатора, исходя из существующих разновидностей данного оборудования, выполняемых функций и внешнего вида.

Что такое трансформатор

Трансформаторами называют электромагнитные аппараты, передающие электрическую энергию посредством магнитного поля по принципу индукции, и преобразующие её характеристики в процессе передачи. Подобный агрегат состоит из сердечника, первичной и вторичной обмоток. Разница в характеристиках на входе и выходе достигается различным количеством витков на первичной и вторичной катушках.

Принцип работы трансформатораДанные агрегаты различаются по следующим особенностям:

- количеству фаз и обмоток на выходе;

- повышению или понижению характеристик на выходе;

- присутствию возможности регулирования.

Указанные устройства используются в различных электрических установках и приборах, в качестве силового оборудования на подстанциях.

Что такое автотрансформатор

Автотрансформатором называют разновидность трансформатора, у которого катушки на входе и выходе обладают прямой электрической связью, помимо магнитной. Их обмотка снабжается несколькими выходами, позволяющими подключаться к контактам с разными характеристиками напряжений.

Производятся следующие разновидности таких установок:

Также в трёхфазных цепях можно устанавливать по три однофазных автотрансформатора, соединив их в виде звезды или треугольника.

Основные отличия

Указанные приборы отличаются принципом работы и внешним видом. Далее – детальнее о различиях указанного оборудования.

По принципу работы

Исходя из конструктивных особенностей, различия данных агрегатов состоят в том, что у трансформаторов отсутствует прямая электрическая связь, а у автотрансформаторов она имеется.

Эти машины различаются по количеству обмоток – с одной у автотрансформатора и двумя или более у трансформатора.

Автотрансформатор отличается большим показателем КПД, но меньшим диапазоном преобразования электрических характеристик в процессе передачи.

Визуальные

Внешне подобное оборудование отличается тем, что трансформаторы намного массивнее автоматических устройств за счёт того, что в данном случае применяется только одна обмотка. В остальном визуальные отличия неспециалисту выявить сложно.

Каждый вид электрического оборудования разрабатывался, исходя из поставленных задач и предусмотренного функционального назначения. Поэтому и трансформаторы, и автотрансформаторы получили широкую область применения в бытовой сфере и промышленном производстве. Но в силу конструктивных особенностей, вторые из них больше используются на промышленных предприятиях, поскольку их применение в бытовой сфере ограничивает большая опасность при эксплуатации, что можно преодолеть на производстве оборудованием надёжного заземления.

Что такое трансформатор (и как он работает)?

Что такое трансформатор?

Принцип работы трансформатора

Принцип работы трансформатора очень прост. Взаимная индукция между двумя или более обмотками (также известными как катушки) позволяет передавать электрическую энергию между цепями. Этот принцип более подробно поясняется ниже.

Теория трансформатора

Допустим, у вас есть одна обмотка (также известная как катушка), которая питается от переменного электрического источника.Переменный ток через обмотку создает непрерывно изменяющийся и переменный поток, окружающий обмотку.

Если к этой обмотке приблизить другую обмотку, некоторая часть этого переменного магнитного потока соединится со второй обмоткой. Поскольку этот поток постоянно изменяется по своей амплитуде и направлению, во второй обмотке или катушке должна быть изменяющаяся магнитная связь.

Согласно закону электромагнитной индукции Фарадея, во второй обмотке возникает ЭДС.Если цепь этой вторичной обмотки замкнута, то через нее будет протекать ток. Это основной принцип работы трансформатора .

Давайте использовать электрические символы, чтобы наглядно это показать. Обмотка, которая получает электроэнергию от источника, известна как «первичная обмотка». На схеме ниже это «Первая катушка».

Обмотка, которая дает желаемое выходное напряжение за счет взаимной индукции, обычно известна как «вторичная обмотка». Это «Вторая катушка» на схеме выше.

Трансформатор, увеличивающий напряжение между первичной и вторичной обмотками, определяется как повышающий трансформатор. И наоборот, трансформатор, который снижает напряжение между первичной и вторичной обмотками, определяется как понижающий трансформатор.

Увеличивает или понижает трансформатор уровень напряжения, зависит от относительного количества витков между первичной и вторичной сторонами трансформатора.

Если на первичной обмотке больше витков, чем на вторичной, то напряжение будет уменьшаться (понижаться).

Если на первичной обмотке меньше витков, чем на вторичной обмотке, то напряжение возрастет (пошагово).

Хотя приведенная выше схема трансформатора теоретически возможна в идеальном трансформаторе, это не очень практично. Это связано с тем, что на открытом воздухе только очень малая часть потока, создаваемого первой катушкой, будет связываться со второй катушкой. Таким образом, ток, протекающий по замкнутой цепи, подключенной ко вторичной обмотке, будет чрезвычайно мал (и его трудно измерить).

Скорость изменения потокосцепления зависит от количества связанного потока со второй обмоткой. Таким образом, в идеале почти весь поток первичной обмотки должен быть связан со вторичной обмоткой. Это эффективно и рационально достигается за счет использования трансформатора с сердечником. Это обеспечивает путь с низким сопротивлением, общий для обеих обмоток.

Назначение сердечника трансформатора — обеспечить путь с низким сопротивлением, через который проходит максимальное количество магнитного потока, создаваемого первичной обмоткой, и соединяется с вторичной обмоткой.

Ток, который первоначально проходит через трансформатор при его включении, называется пусковым током трансформатора.

Если вы предпочитаете анимированное объяснение, ниже представлено видео, объясняющее, как именно работает трансформатор:

Детали и конструкция трансформатора

Три основные части трансформатора:

- Первичная обмотка трансформатора

- Магнитный сердечник трансформатора

- Вторичная обмотка трансформатора

Первичная обмотка трансформатора

Который создает магнитный поток, когда он подключен к источнику электроэнергии.

Магнитный сердечник трансформатора

Магнитный поток, создаваемый первичной обмоткой, который проходит через этот путь с низким сопротивлением, связанный с вторичной обмоткой, и создает замкнутую магнитную цепь.

Вторичная обмотка трансформатора

Поток, создаваемый первичной обмоткой, проходит через сердечник и соединяется со вторичной обмоткой. Эта обмотка также намотана на тот же сердечник и дает желаемую мощность трансформатора .

Новая архитектура нейронной сети для понимания языков

Декодер работает аналогично, но генерирует по одному слову слева направо.Он касается не только других ранее сгенерированных слов, но и окончательных представлений, созданных кодировщиком. Поток информации

Помимо вычислительной производительности и более высокой точности, еще одним интригующим аспектом преобразователя является то, что мы можем визуализировать, на какие другие части предложения сеть обращает внимание при обработке или переводе данного слова, таким образом получая представление о том, как распространяется информация через сеть.

Чтобы проиллюстрировать это, мы выбрали пример, связанный с явлением, которое, как известно, является сложным для систем машинного перевода: разрешение кореферентности.Рассмотрим следующие предложения и их французский перевод:

| Распределение собственного внимания кодировщика для слова «оно» с 5-го по 6-й уровень Трансформатора, обученного переводу с английского на французский (одна из восьми глав внимания). |

Фактически, с небольшой адаптацией, та же сеть, которую мы использовали для перевода с английского на немецкий, превзошла все ранее предложенные подходы к синтаксическому анализу, кроме одного.

Следующие шаги

Мы очень воодушевлены будущим потенциалом Transformer и уже начали применять его для решения других задач, связанных не только с естественным языком, но и с очень разными входами и выходами, такими как изображения и видео.Наши текущие эксперименты значительно ускоряются библиотекой Tensor2Tensor, исходный код которой мы недавно открыли. Фактически, после загрузки библиотеки вы можете обучить свои собственные сети Transformer для перевода и синтаксического анализа, вызвав всего несколько команд. Мы надеемся, что вы попробуете, и с нетерпением ждем возможности увидеть, что сообщество может сделать с Transformer.

Благодарности

Это исследование проводили Ашиш Васвани, Ноам Шазир, Ники Пармар, Якоб Ушкорейт, Лайон Джонс, Эйдан Н.Гомес, Лукаш Кайзер и Илья Полосухин. Дополнительная благодарность Дэвиду Ченеллу за создание приведенной выше анимации.

. Нейронные сети, в частности рекуррентные нейронные сети (RNN), в настоящее время составляют основу ведущих подходов к решению задач понимания языка, таких как языковое моделирование, машинный перевод и ответы на вопросы. В статье «Внимание — это все, что вам нужно» мы представляем Transformer, новую архитектуру нейронной сети, основанную на механизме самовнимания, который, по нашему мнению, особенно хорошо подходит для понимания языка.

В нашей статье мы показываем, что Transformer превосходит как рекуррентные, так и сверточные модели в тестах перевода с академического английского на немецкий и с английского на французский. Помимо более высокого качества перевода, Transformer требует меньше вычислений для обучения и гораздо лучше подходит для современного оборудования для машинного обучения, ускоряя обучение на порядок.

| Показатели BLEU (чем выше, тем лучше) отдельных моделей в стандартном тесте перевода WMT newstest2014 с английского на немецкий. |

| Показатели BLEU (чем выше, тем лучше) отдельных моделей в стандартном тесте перевода WMT newstest2014 с английского на французский. |

Нейронные сети обычно обрабатывают язык, генерируя представления в векторном пространстве фиксированной или переменной длины. Начав с представлений отдельных слов или даже частей слов, они собирают информацию из окружающих слов, чтобы определить значение заданной части языка в контексте.Например, чтобы выбрать наиболее вероятное значение и подходящее представление слова «банк» в предложении «Я прибыл в банк после пересечения…», необходимо знать, заканчивается ли предложение словом «… дорога». или «… река».

RNN в последние годы стали типичной сетевой архитектурой для перевода, обрабатывая язык последовательно слева направо или справа налево. При чтении одного слова за раз это вынуждает RNN выполнять несколько шагов для принятия решений, которые зависят от слов, находящихся далеко друг от друга.Обрабатывая приведенный выше пример, RNN может определить, что «берег», скорее всего, будет относиться к берегу реки, только после пошагового чтения каждого слова между «берегом» и «рекой». Предыдущие исследования показали, что, грубо говоря, чем больше требуются такие шаги для принятия решений, тем сложнее повторяющейся сети научиться принимать эти решения.

Последовательный характер RNN также затрудняет полное использование преимуществ современных быстрых вычислительных устройств, таких как TPU и графические процессоры, которые превосходны при параллельной, а не последовательной обработке.Сверточные нейронные сети (CNN) намного менее последовательны, чем RNN, но в архитектурах CNN, таких как ByteNet или ConvS2S, количество шагов, необходимых для объединения информации из удаленных частей входных данных, по-прежнему растет с увеличением расстояния.

Трансформатор

Напротив, Трансформатор выполняет только небольшое постоянное количество шагов (выбирается эмпирически). На каждом этапе он применяет механизм самовнимания, который непосредственно моделирует отношения между всеми словами в предложении, независимо от их положения.В предыдущем примере «Я прибыл на берег после перехода через реку», чтобы определить, что слово «берег» относится к берегу реки, а не к финансовому учреждению, Трансформатор может научиться сразу же обращать внимание на слово «река» и примите это решение за один шаг. Фактически, в нашей модели перевода с английского на французский мы наблюдаем именно такое поведение.

Более конкретно, чтобы вычислить следующее представление для данного слова — например, «банк» — Transformer сравнивает его с каждым другим словом в предложении.Результатом этих сравнений является оценка внимания к каждому второму слову в предложении. Эти оценки внимания определяют, насколько каждое из других слов должно способствовать следующему представлению слова «банк». В этом примере устраняющая неоднозначность «река» может получить высокий балл внимания при вычислении нового представления для «банка». Затем оценки внимания используются в качестве весов для средневзвешенного значения представлений всех слов, которое подается в полностью подключенную сеть для создания нового представления для слова «берег», отражающего, что в предложении говорится о берегу реки.

Анимация ниже показывает, как мы применяем Transformer к машинному переводу. Нейронные сети для машинного перевода обычно содержат кодировщик, считывающий входное предложение и генерирующий его представление. Затем декодер генерирует выходное предложение слово за словом, обращаясь к представлению, сгенерированному кодером. Преобразователь начинает с генерации начальных представлений или вложений для каждого слова. Они представлены незакрашенными кружками. Затем, используя самовнимание, он собирает информацию из всех других слов, создавая новое представление для каждого слова, проинформированное всем контекстом, представленным заполненными шариками.Затем этот шаг повторяется несколько раз параллельно для всех слов, последовательно генерируя новые представления.

Поток информации

Помимо вычислительной производительности и более высокой точности, еще одним интригующим аспектом преобразователя является то, что мы можем визуализировать, на какие другие части предложения сеть обращает внимание при обработке или переводе данного слова, таким образом получая представление о том, как распространяется информация через сеть.

Чтобы проиллюстрировать это, мы выбрали пример, связанный с явлением, которое, как известно, является сложным для систем машинного перевода: разрешение кореферентности. Рассмотрим следующие предложения и их французский перевод:

| Распределение собственного внимания кодировщика для слова «оно» с 5-го по 6-й уровень Трансформатора, обученного переводу с английского на французский (одна из восьми глав внимания). |

Фактически, с небольшой адаптацией, та же сеть, которую мы использовали для перевода с английского на немецкий, превзошла все ранее предложенные подходы к синтаксическому анализу, кроме одного.

Следующие шаги

Мы очень воодушевлены будущим потенциалом Transformer и уже начали применять его для решения других задач, связанных не только с естественным языком, но и с очень разными входами и выходами, такими как изображения и видео.Наши текущие эксперименты значительно ускоряются библиотекой Tensor2Tensor, исходный код которой мы недавно открыли. Фактически, после загрузки библиотеки вы можете обучить свои собственные сети Transformer для перевода и синтаксического анализа, вызвав всего несколько команд. Мы надеемся, что вы попробуете, и с нетерпением ждем возможности увидеть, что сообщество может сделать с Transformer.

Благодарности

Это исследование проводили Ашиш Васвани, Ноам Шазир, Ники Пармар, Якоб Ушкорейт, Лайон Джонс, Эйдан Н.Гомес, Лукаш Кайзер и Илья Полосухин. Дополнительная благодарность Дэвиду Ченеллу за создание приведенной выше анимации.

The Illustrated Transformer — Джей Аламмар — Визуализация машинного обучения по одной концепции за раз.

Обсуждения:

Hacker News (65 баллов, 4 комментария), Reddit r / MachineLearning (29 баллов, 3 комментария)

Переводы: Испанский, Китайский (упрощенный), Корейский, Русский, Вьетнамский, Французский, Японский

Смотреть: лекция MIT по теме «Глубокое обучение» со ссылкой на этот пост

В предыдущем посте мы рассмотрели «Внимание» — повсеместный метод в современных моделях глубокого обучения.Внимание — это концепция, которая помогла повысить производительность приложений нейронного машинного перевода. В этом посте мы рассмотрим The Transformer — модель, которая привлекает внимание для повышения скорости обучения этих моделей. Трансформеры превосходят модель нейронного машинного перевода Google в определенных задачах. Однако наибольшее преимущество заключается в том, что The Transformer позволяет распараллеливать. Фактически, Google Cloud рекомендует использовать The Transformer в качестве эталонной модели для использования своего предложения Cloud TPU.Итак, давайте попробуем разбить модель на части и посмотрим, как она работает.

Трансформатор был предложен в статье «Внимание — это все, что вам нужно». Его реализация в TensorFlow доступна как часть пакета Tensor2Tensor. Группа НЛП из Гарварда создала руководство с аннотациями к статье с использованием PyTorch. В этом посте мы попытаемся немного упростить вещи и представить концепции одну за другой, чтобы, надеюсь, облегчить понимание людям без глубоких знаний предмета.

2020 Обновление : я создал видео «Рассказанный трансформер», в котором более мягкий подход к теме:

Взгляд высокого уровня

Давайте начнем с рассмотрения модели как единого черного ящика. В приложении машинного перевода оно берет предложение на одном языке и выводит его перевод на другом.

Раскрывая эту доброту Оптимуса Прайма, мы видим компонент кодирования, компонент декодирования и связи между ними.

Компонент кодирования представляет собой стек кодировщиков (на бумаге шесть из них складываются друг на друга — в цифре шесть нет ничего волшебного, можно определенно поэкспериментировать с другими компоновками). Компонент декодирования представляет собой стек декодеров с одинаковым числом.

Все кодировщики идентичны по структуре (но у них нет общих весов). Каждый из них разбит на два подслоя:

Входные данные кодировщика сначала проходят через слой самовнимания — слой, который помогает кодировщику смотреть на другие слова во входном предложении, когда он кодирует определенное слово.Позже мы подробнее рассмотрим самовнимание.

Выходные данные слоя самовнимания передаются в нейронную сеть с прямой связью. Точно такая же сеть прямого распространения независимо применяется к каждой позиции.

В декодере есть оба этих уровня, но между ними есть уровень внимания, который помогает декодеру сосредоточиться на соответствующих частях входного предложения (аналогично тому, что делает внимание в моделях seq2seq).

Использование тензоров в картине

Теперь, когда мы увидели основные компоненты модели, давайте начнем смотреть на различные векторы / тензоры и то, как они перемещаются между этими компонентами, чтобы превратить входные данные обученной модели в выходные данные.

Как и в случае с приложениями НЛП в целом, мы начинаем с преобразования каждого входного слова в вектор с помощью алгоритма встраивания.

Каждое слово вложено в вектор размером 512. Мы представим эти векторы этими простыми прямоугольниками.

Встраивание происходит только в самый нижний кодировщик. Абстракция, которая является общей для всех кодировщиков, заключается в том, что они получают список векторов, каждый из которых имеет размер 512. В нижнем кодировщике это будет слово embeddings, но в других кодировщиках это будет выход кодировщика, который находится непосредственно под .Размер этого списка — это гиперпараметр, который мы можем установить — в основном это будет длина самого длинного предложения в нашем наборе обучающих данных.

После встраивания слов в нашу входную последовательность каждое из них проходит через каждый из двух уровней кодировщика.

Здесь мы начинаем видеть одно ключевое свойство преобразователя, а именно то, что слово в каждой позиции проходит свой собственный путь в кодировщике. Между этими путями на уровне самовнимания есть зависимости.Однако уровень прямой связи не имеет этих зависимостей, и, таким образом, различные пути могут выполняться параллельно при прохождении через слой прямой связи.

Затем мы заменим пример более коротким предложением и посмотрим, что происходит на каждом подуровне кодировщика.

Теперь мы кодируем!

Как мы уже упоминали, кодировщик получает в качестве входных данных список векторов. Он обрабатывает этот список, передавая эти векторы в слой «самовнимания», затем в нейронную сеть с прямой связью, а затем отправляет выходные данные вверх следующему кодировщику.

Слово в каждой позиции проходит через процесс самовнимания. Затем каждый из них проходит через нейронную сеть с прямой связью — точно такую же сеть с каждым вектором, протекающим через нее отдельно.

Самовнимание на высоком уровне

Не дайте себя обмануть, если я использую слово «самовнимание», как будто это понятие должно быть знакомо каждому. Я лично никогда не сталкивался с этой концепцией до тех пор, пока не прочитал статью «Все, что вам нужно». Давайте разберемся, как это работает.

Скажем, следующее предложение является вводным предложением, которое мы хотим перевести:

” Животное не переходило улицу, потому что оно слишком устало ”

Что означает «оно» в этом предложении? Имеется в виду улица или животное? Это простой вопрос для человека, но не такой простой для алгоритма.

Когда модель обрабатывает слово «оно», самовнимание позволяет ей ассоциировать «это» с «животным».

По мере того, как модель обрабатывает каждое слово (каждую позицию во входной последовательности), самовнимание позволяет ей смотреть на другие позиции во входной последовательности в поисках подсказок, которые могут помочь улучшить кодирование этого слова.

Если вы знакомы с RNN, подумайте о том, как поддержание скрытого состояния позволяет RNN включать свое представление предыдущих слов / векторов, которые она обработала, с текущим, обрабатываемым ею. Самовнимание — это метод, который Трансформер использует для «запекания» других релевантных слов в словах, которые мы обрабатываем в данный момент.

Поскольку мы кодируем слово «оно» в кодировщике №5 (верхний кодировщик в стеке), часть механизма внимания фокусировалась на «Животном» и запекла часть его представления в кодировке «оно».

Обязательно ознакомьтесь с записной книжкой Tensor2Tensor, где вы можете загрузить модель Transformer и изучить ее с помощью этой интерактивной визуализации.

Самостоятельное внимание в деталях

Давайте сначала посмотрим, как вычислить самовнимание с помощью векторов, а затем перейдем к рассмотрению того, как это на самом деле реализовано — с помощью матриц.

Первый шаг при вычислении самовнимания — создать три вектора из каждого входного вектора кодировщика (в данном случае — вложение каждого слова).Итак, для каждого слова мы создаем вектор запроса, вектор ключа и вектор значения. Эти векторы создаются путем умножения вложения на три матрицы, которые мы обучили в процессе обучения.

Обратите внимание, что эти новые векторы меньше по размерности, чем вектор внедрения. Их размерность составляет 64, в то время как векторы ввода / вывода встраивания и кодировщика имеют размерность 512. Они НЕ ДОЛЖНЫ быть меньше, это выбор архитектуры, позволяющий сделать вычисление многогранного внимания (в основном) постоянным.

Умножение x1 на весовую матрицу WQ дает q1, вектор «запроса», связанный с этим словом. В итоге мы создаем проекцию «запроса», «ключа» и «значения» для каждого слова во входном предложении.

Что такое векторы «запроса», «ключа» и «значения»?

Это абстракции, которые полезны для вычисления внимания и размышлений о нем. Когда вы перейдете к чтению того, как рассчитывается внимание ниже, вы будете знать почти все, что вам нужно знать о роли каждого из этих векторов.

Второй шаг в вычислении самовнимания — это подсчет баллов. Предположим, мы вычисляем внимание к себе для первого слова в этом примере — «Мышление». Нам нужно сопоставить каждое слово входного предложения с этим словом. Оценка определяет, сколько внимания следует уделять другим частям входного предложения, когда мы кодируем слово в определенной позиции.

Оценка рассчитывается как скалярное произведение вектора запроса на ключевой вектор соответствующего слова, которое мы оцениваем.Итак, если мы обрабатываем самовнимание для слова в позиции №1, первая оценка будет скалярным произведением q1 и k1. Вторая оценка будет скалярным произведением q1 и k2.

Третий и четвертый этапы заключаются в разделении оценок на 8 (квадратный корень из размерности ключевых векторов, используемых в статье — 64. Это приводит к получению более стабильных градиентов. Здесь могут быть другие возможные значения, но это значение по умолчанию), затем передайте результат через операцию softmax.Softmax нормализует оценки, чтобы все они были положительными и в сумме составляли 1.

Эта оценка softmax определяет, насколько каждое слово будет выражено в этой позиции. Очевидно, что слово в этой позиции будет иметь наивысший балл softmax, но иногда полезно обратить внимание на другое слово, имеющее отношение к текущему слову.

Пятый шаг — это умножение каждого вектора значений на оценку softmax (при подготовке к их суммированию). Интуиция здесь заключается в том, чтобы сохранить неизменными значения слов, на которых мы хотим сосредоточиться, и заглушить не относящиеся к делу слова (умножив их на крошечные числа, такие как 0.001, например).

Шестой этап заключается в суммировании векторов взвешенных значений. Это производит вывод слоя самовнимания в этой позиции (для первого слова).

На этом расчет самовнимания завершен. Результирующий вектор — это тот, который мы можем отправить в нейронную сеть с прямой связью. Однако в реальной реализации этот расчет выполняется в матричной форме для более быстрой обработки. Итак, давайте посмотрим на это теперь, когда мы увидели интуитивное вычисление на уровне слов.

Матрица расчета самовнимания

Первым шагом является вычисление матриц запроса, ключа и значения. Мы делаем это, упаковывая наши вложения в матрицу X и умножая ее на матрицы весов, которые мы обучили (WQ, WK, WV).

Каждая строка в матрице X соответствует слову во входном предложении. Мы снова видим разницу в размере вектора встраивания (512 или 4 прямоугольника на рисунке) и векторов q / k / v (64 или 3 прямоугольника на рисунке).

Наконец, , поскольку мы имеем дело с матрицами, мы можем объединить шаги со второго по шестой в одну формулу, чтобы вычислить результаты слоя самовнимания.

Расчет самовнимания в матричной форме

Многоголовый зверь

В статье дополнительно усовершенствован слой самовнимания, добавлен механизм, называемый «многоголовым» вниманием. Это улучшает производительность слоя внимания двумя способами:

-

Расширяет способность модели фокусироваться на разных позициях. Да, в приведенном выше примере z1 содержит немного любой другой кодировки, но в ней может преобладать само слово.Было бы полезно, если бы мы переводили предложение вроде «Животное не перешло улицу, потому что оно слишком устало», мы хотели бы знать, к какому слову «оно» относится.

-

Он дает слою внимания несколько «подпространств представления». Как мы увидим далее, с многоголовым вниманием у нас есть не только один, но и несколько наборов весовых матриц запроса / ключа / значения (Трансформатор использует восемь головок внимания, поэтому мы получаем восемь наборов для каждого кодировщика / декодера). . Каждый из этих наборов инициализируется случайным образом.Затем, после обучения, каждый набор используется для проецирования входных вложений (или векторов из нижних кодировщиков / декодеров) в другое подпространство представления.

С многоголовым вниманием мы поддерживаем отдельные весовые матрицы Q / K / V для каждой головы, в результате чего получаются разные матрицы Q / K / V. Как и раньше, мы умножаем X на матрицы WQ / WK / WV, чтобы получить матрицы Q / K / V.

Если мы проделаем тот же самый расчет самовнимания, который мы описали выше, всего восемь раз с разными весовыми матрицами, мы получим восемь разных Z-матриц

Это оставляет нам небольшую проблему.Слой прямой связи не ожидает восьми матриц — он ожидает единственную матрицу (вектор для каждого слова). Итак, нам нужен способ сжать эти восемь в единую матрицу.

Как мы это делаем? Мы объединяем матрицы, а затем умножаем их на дополнительную матрицу весов WO.

Вот и все, что нужно для многоглавого самовнимания. Я понимаю, что это довольно много матриц. Позвольте мне попытаться объединить их все в один визуал, чтобы мы могли рассматривать их в одном месте

Теперь, когда мы коснулись головок внимания, давайте вернемся к нашему предыдущему примеру, чтобы увидеть, на чем фокусируются различные головы внимания, когда мы кодируем слово «оно» в нашем примере предложения:

Когда мы кодируем слово «оно», одна голова внимания больше всего сосредотачивается на «животном», в то время как другая фокусируется на «усталом» — в некотором смысле, представление модели слова «оно» вписывается в некоторые из представлений. как «животное», так и «уставшее».

Однако, если мы добавим все внимание к изображению, интерпретировать вещи будет сложнее:

Представление порядка последовательности с использованием позиционного кодирования

В модели, которую мы описали до сих пор, отсутствует одна вещь, так это способ учесть порядок слов во входной последовательности.

Чтобы решить эту проблему, преобразователь добавляет вектор к каждому встраиванию входа. Эти векторы следуют определенному шаблону, который модель изучает, что помогает ей определять положение каждого слова или расстояние между разными словами в последовательности.Интуиция здесь заключается в том, что добавление этих значений к вложениям обеспечивает значимые расстояния между векторами встраивания, когда они проецируются в векторы Q / K / V и во время внимания скалярного произведения.

Чтобы дать модели ощущение порядка слов, мы добавляем векторы позиционного кодирования, значения которых следуют определенному шаблону.

Если мы предположим, что вложение имеет размерность 4, фактическое позиционное кодирование будет выглядеть так:

Реальный пример позиционного кодирования с размером вложения игрушки 4

Как может выглядеть этот узор?

На следующем рисунке каждая строка соответствует позиционному кодированию вектора.Таким образом, первая строка будет вектором, который мы добавим к встраиванию первого слова во входной последовательности. Каждая строка содержит 512 значений — каждое от 1 до -1. Мы присвоили им цветовую кодировку, чтобы узор был виден.

Реальный пример позиционного кодирования для 20 слов (строк) с размером встраивания 512 (столбцов). Вы можете видеть, что он разделен пополам по центру. Это потому, что значения левой половины генерируются одной функцией (которая использует синус), а правая половина генерируется другой функцией (которая использует косинус).Затем они объединяются, чтобы сформировать каждый из векторов позиционного кодирования.

Формула позиционного кодирования описана в статье (раздел 3.5). Вы можете увидеть код для генерации позиционных кодировок в get_timing_signal_1d () . Это не единственный возможный метод позиционного кодирования. Однако это дает преимущество возможности масштабирования до невидимой длины последовательностей (например, если нашу обученную модель просят перевести предложение длиннее, чем любое из предложений в нашем обучающем наборе).

Июль 2020 Обновление: Позиционное кодирование, показанное выше, взято из реализации Transformer2Transformer. Метод, показанный в статье, немного отличается тем, что он не соединяет напрямую, а переплетает два сигнала. На следующем рисунке показано, как это выглядит. Вот код для его создания:

Остатки

Одна деталь в архитектуре кодера, которую мы должны упомянуть, прежде чем двигаться дальше, заключается в том, что каждый подуровень (самовнимание, ffnn) в каждом кодере имеет остаточное соединение вокруг себя, за которым следует этап нормализации уровня. .

Если мы визуализируем векторы и операцию уровня-нормы, связанную с самовниманием, это будет выглядеть так:

Это также относится к подуровням декодера. Если представить себе преобразователь из двух стековых кодировщиков и декодеров, он будет выглядеть примерно так:

Сторона декодера

Теперь, когда мы рассмотрели большинство концепций кодировщика, мы в основном знаем, как работают компоненты декодеров.Но давайте посмотрим, как они работают вместе.

Кодер запускает обработку входной последовательности. Выходной сигнал верхнего кодера затем преобразуется в набор векторов внимания K и V. Они должны использоваться каждым декодером на его уровне «внимание кодер-декодер», который помогает декодеру сосредоточиться на соответствующих местах во входной последовательности:

После завершения этапа кодирования мы начинаем этап декодирования. Каждый шаг в фазе декодирования выводит элемент из выходной последовательности (в данном случае предложение английского перевода).

Следующие шаги повторяют процесс до тех пор, пока не будет достигнут специальный символ, указывающий, что декодер трансформатора завершил свой вывод. Выходные данные каждого шага поступают в нижний декодер на следующем временном шаге, и декодеры выводят свои результаты декодирования так же, как это сделали кодеры. И так же, как мы поступили с входами кодировщика, мы встраиваем и добавляем позиционное кодирование к этим входам декодера, чтобы указать положение каждого слова.

Слои самовнимания в декодере работают немного иначе, чем в кодировщике:

В декодере слою самовнимания разрешено обращать внимание только на более ранние позиции в выходной последовательности.Это делается путем маскировки будущих позиций (установка для них значений -inf ) перед шагом softmax при вычислении самовнимания.

Уровень «Внимание кодировщика-декодера» работает так же, как многоголовое самовнимание, за исключением того, что он создает свою матрицу запросов из уровня ниже и берет матрицу ключей и значений из выходных данных стека кодировщика.

Последний линейный слой и слой Softmax

Стек декодера выводит вектор с плавающей запятой. Как превратить это в слово? Это работа последнего слоя Linear, за которым следует слой Softmax.

Линейный слой — это простая полносвязная нейронная сеть, которая проецирует вектор, созданный стеком декодеров, в гораздо более крупный вектор, называемый вектором логитов.

Предположим, что наша модель знает 10 000 уникальных английских слов («выходной словарь» нашей модели), которые она выучила из набора обучающих данных. Это сделало бы вектор логитов шириной 10 000 ячеек — каждая ячейка соответствует количеству уникального слова. Вот как мы интерпретируем вывод модели, за которой следует линейный слой.

Затем слой softmax превращает эти оценки в вероятности (все положительные, все в сумме дают 1,0). Выбирается ячейка с наибольшей вероятностью, и слово, связанное с ней, создается в качестве выходных данных для этого временного шага.

Этот рисунок начинается снизу с вектора, полученного на выходе стека декодера. Затем оно превращается в выходное слово.

Итоги обучения

Теперь, когда мы рассмотрели весь процесс прямого прохода через обученный преобразователь, было бы полезно взглянуть на интуицию обучения модели.

Во время обучения неподготовленная модель должна пройти точно такой же прямой проход. Но поскольку мы обучаем его на помеченном наборе обучающих данных, мы можем сравнить его выходные данные с фактическими правильными выходными данными.

Для наглядности предположим, что наш выходной словарь содержит только шесть слов («а», «я», «я», «спасибо», «ученик» и «