Что такое трансформатор и как он работает. Какие бывают виды трансформаторов. Где применяются трансформаторы в энергетике и электротехнике. Как выбрать трансформатор для конкретных задач.

Что такое трансформатор и принцип его работы

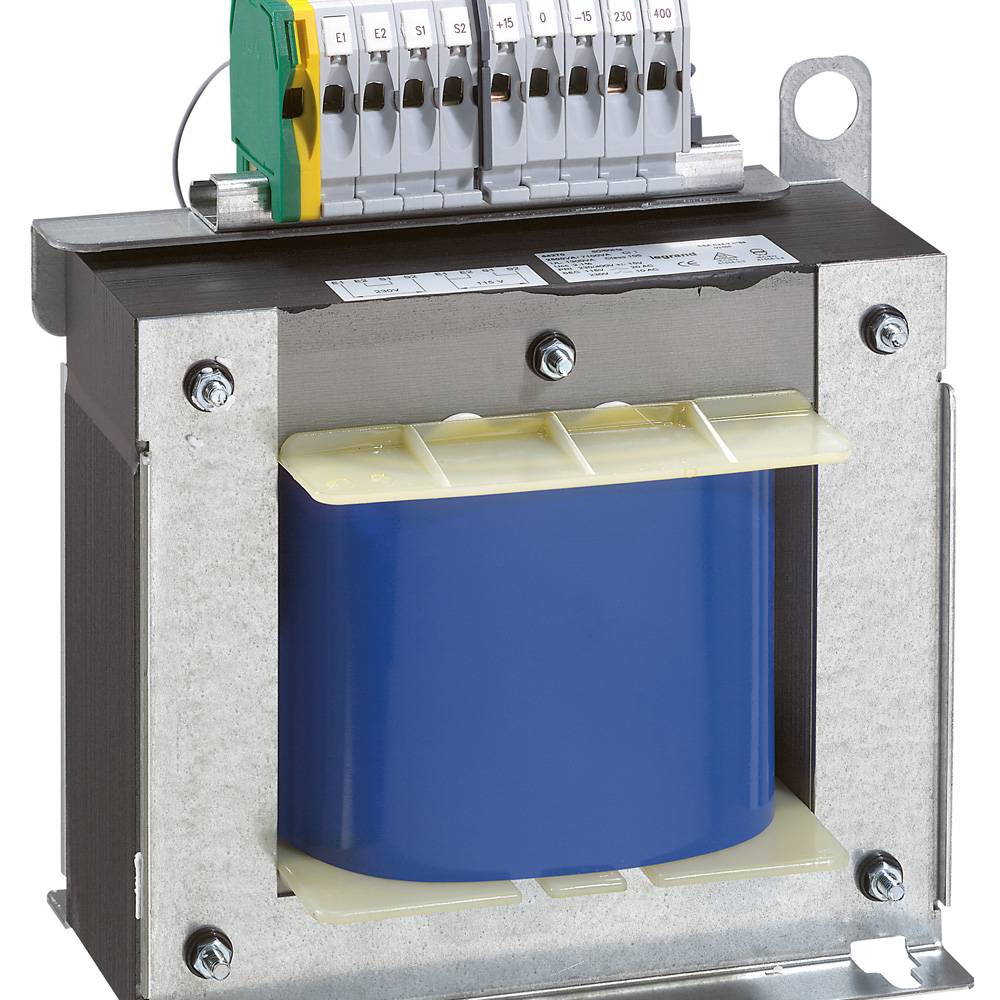

Трансформатор — это статическое электромагнитное устройство, предназначенное для преобразования переменного тока одного напряжения в переменный ток другого напряжения той же частоты. Основными элементами трансформатора являются:

- Магнитопровод (сердечник) из ферромагнитного материала

- Первичная обмотка

- Вторичная обмотка

Принцип действия трансформатора основан на явлении электромагнитной индукции. При подаче переменного напряжения на первичную обмотку в магнитопроводе возникает переменный магнитный поток. Этот поток, пронизывая витки вторичной обмотки, индуцирует в ней ЭДС. Величина индуцированной ЭДС зависит от числа витков обмотки.

Основные виды трансформаторов

По назначению трансформаторы подразделяются на следующие основные виды:

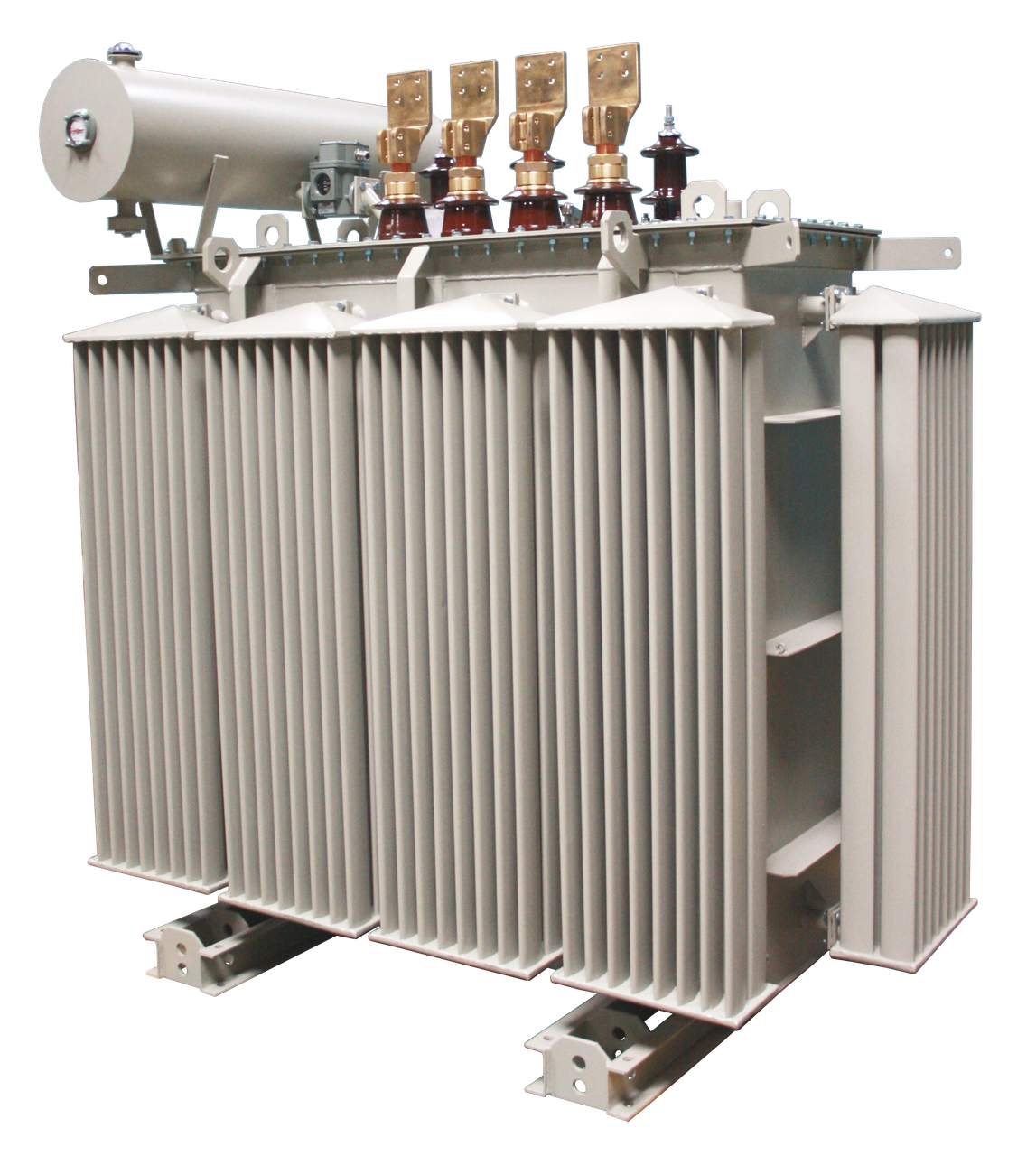

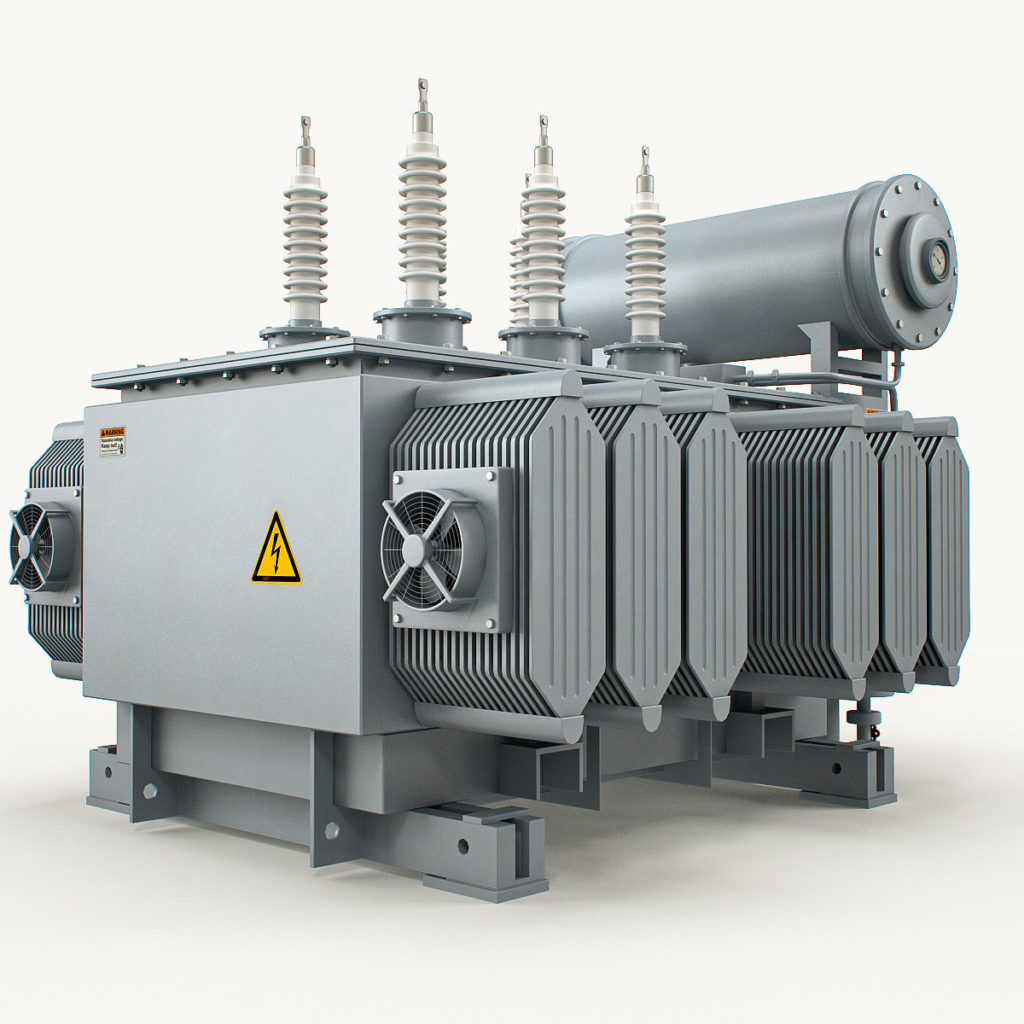

Силовые трансформаторы

Предназначены для преобразования электроэнергии в электросетях. Применяются на электростанциях, подстанциях, в системах электроснабжения. Мощность силовых трансформаторов может достигать сотен мегавольт-ампер.

Измерительные трансформаторы

Используются для преобразования больших токов и напряжений в малые стандартные значения с целью подключения измерительных приборов и устройств релейной защиты. Бывают трансформаторы тока и трансформаторы напряжения.

Сварочные трансформаторы

Применяются для питания сварочной дуги переменным током пониженного напряжения. Обеспечивают большой сварочный ток при низком напряжении.

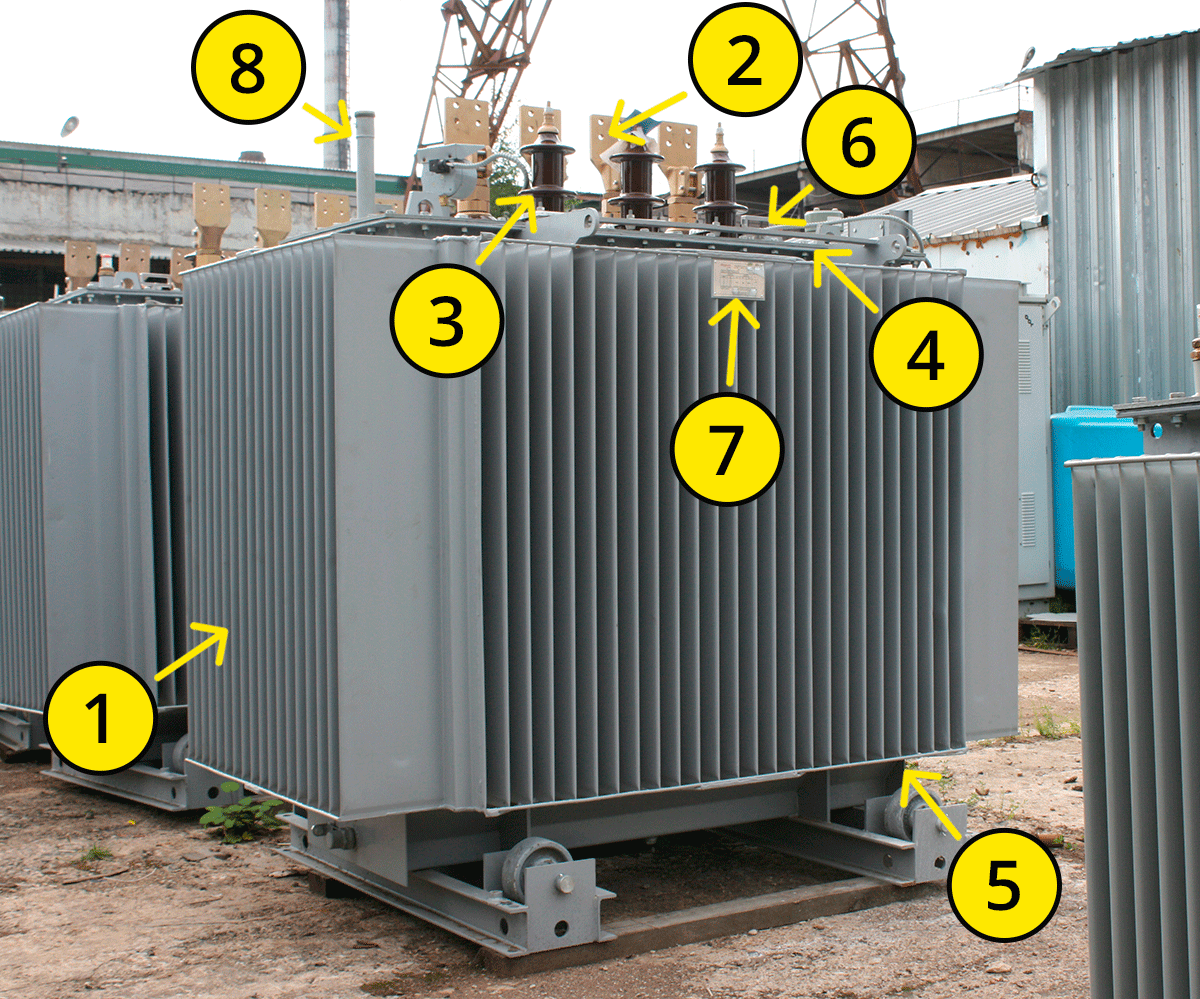

Устройство силового трансформатора

Основными конструктивными элементами силового трансформатора являются:

- Магнитопровод из электротехнической стали

- Обмотки высокого и низкого напряжения

- Бак с трансформаторным маслом

- Вводы высокого и низкого напряжения

- Система охлаждения

- Устройство регулирования напряжения

Обмотки размещаются на стержнях магнитопровода. Активная часть помещается в бак, заполненный трансформаторным маслом для изоляции и охлаждения. На крышке бака располагаются вводы и элементы системы охлаждения.

Применение трансформаторов в энергетике

Трансформаторы являются важнейшими элементами систем производства, передачи и распределения электроэнергии. Основные области их применения:

- Повышение напряжения на электростанциях для передачи электроэнергии

- Понижение напряжения на подстанциях для распределения потребителям

- Регулирование напряжения в электрических сетях

- Преобразование числа фаз и частоты тока

- Гальваническая развязка электрических цепей

Без трансформаторов невозможно создание современных систем электроснабжения. Они обеспечивают экономичную передачу электроэнергии на большие расстояния.

Как выбрать трансформатор для конкретных задач

При выборе трансформатора необходимо учитывать следующие основные параметры:

- Мощность

- Напряжение первичной и вторичной обмоток

- Ток нагрузки

- Режим работы (длительный, кратковременный)

- Условия эксплуатации

- Способ охлаждения

- Габариты и масса

Для правильного выбора трансформатора желательно проконсультироваться со специалистом. Это позволит подобрать оптимальный вариант для конкретных условий применения.

Техническое обслуживание трансформаторов

Для обеспечения надежной работы трансформаторов необходимо проводить их регулярное техническое обслуживание, включающее:

- Внешний осмотр

- Проверку уровня и качества масла

- Измерение сопротивления изоляции обмоток

- Проверку устройств защиты

- Очистку изоляторов

- Подтяжку контактных соединений

Периодичность и объем работ по обслуживанию определяются типом трансформатора и условиями его эксплуатации. Своевременное техническое обслуживание позволяет продлить срок службы трансформатора и повысить надежность электроснабжения.

Современные тенденции в трансформаторостроении

Основными направлениями совершенствования трансформаторов в настоящее время являются:

- Снижение потерь электроэнергии

- Уменьшение массы и габаритов

- Повышение надежности

- Увеличение срока службы

- Применение новых электротехнических материалов

- Совершенствование систем охлаждения

- Внедрение цифровых систем мониторинга и диагностики

Развитие технологий позволяет создавать все более эффективные и экологичные трансформаторы, отвечающие современным требованиям энергетики и промышленности.

Что такое трансформатор: виды, описание

Силовой трансформатор

Силовой трансформатор – трансформатор, который используют для преобразования энергии в электрических сетях, а также установках, которые используют для работы с электрической энергией.

Автотрансформатор

Трансформатор с соединенными напрямую первичной и вторичной обмоткой, что обеспечивает им одновременно и электрическую, и электромагнитную связь. Как правило, обмотка трансформатора обладает минимум 3 выводами, подключение к которым позволяет получить разные напряжения. Одним из основных преимуществ такого типа трансформаторов является высокий КПД (так как преобразовывается лишь часть мощности).

Измерительные трансформаторы

Измерительные трансформаторы применяются в установках переменного тока и служат в целях изоляции цепей измерительных приборов и реле от сети высокого напряжения, а также в целях расширения пределов измерения измерительных приборов. Если бы включение измерительных приборов осуществлялось непосредственно в цепь высокого напряжения, то каждый из приборов мог бы стать попросту опасным для прикосновений. Во избежание этого конструкцию приборов пришлось бы значительно усложнить, так как сечение токоведущих частей должно было бы справляться с большими токами, а их изоляция – справляться с высоким напряжением.

Измерительные трансформаторы можно разделить на два типа: трансформаторы напряжения и трансформаторы тока. Благодаря их использованию появляется возможность эксплуатации одних и тех же устройств со стандартными пределами измерения.

В случае с измерительным трансформатором тока происходит преобразование большого тока в малый, а в случае с измерительным трансформатором напряжение осуществляется изменение высокого напряжения в низкое.

Трансформатор тока

Трансформатор, который используют в целях снижения первичного тока до отметки, применяемой в цепях измерения, управления, защиты и сигнализации. Вторичная обмотка обладает номинальным значением 1А и 5А. Включение первичной обмотки осуществляется в цепь с измеряемым переменным током. В свою очередь, во вторичную подключают измерительные приборы. Ток, который проходит по вторичной обмотке, пропорционален току, который проходит в первичной обмотке на коэффициент трансформации.

Трансформатор напряжения

Трансформатор, который используют в целях преобразования высокого напряжения в более низкое в цепях, в измерительных цепях, а также цепях РЗиА. Благодаря использованию трансформатора появляется возможность изоляции логических цепей защиты и измерительных цепей от цепей высокого напряжения.

Импульсный трансформатор

Трансформатор, который используют в целях преобразования импульсных сигналов, чья длительность доходит до десятков микросекунд, с максимальным сохранением формы импульса. Обычно его применяют в тех случаях, когда требуется передача прямоугольного электрического импульса. Он трансформирует кратковременные видеоимпульсы напряжения, периодическое повторение которых сопровождается высокой скважностью. Как правило, главные требования, которые предъявляются к ИТ, включают в себя передачу формы трансформируемых импульсов напряжения в неискаженном виде. Кроме этого, во время воздействия на вход ИТ того или иного вида напряжения необходимо получить на выходе тот же самый импульс напряжения (в крайнем случае, другой полярности или амплитуды).

Обычно его применяют в тех случаях, когда требуется передача прямоугольного электрического импульса. Он трансформирует кратковременные видеоимпульсы напряжения, периодическое повторение которых сопровождается высокой скважностью. Как правило, главные требования, которые предъявляются к ИТ, включают в себя передачу формы трансформируемых импульсов напряжения в неискаженном виде. Кроме этого, во время воздействия на вход ИТ того или иного вида напряжения необходимо получить на выходе тот же самый импульс напряжения (в крайнем случае, другой полярности или амплитуды).

Разделительный трансформатор

Трансформатор, у которого первичная обмотка электрически никак не связана со вторичными обмотками. Основное предназначение силовых разделительных трансформаторов заключается в повышении безопасности электросетей, требования к которой возрастают в случае касаний земли, а также токоведущих и нетоковедущих частей, находящихся под напряжением в результате повреждения изоляции. Гальваническая развязка электрических цепей обеспечивается за счет сигнальных разделительных трансформаторов.

Пик-трансформатор

Трансформатор, который преобразует напряжение, имеющее синусоидальную форму, в импульсное напряжение, полярность которого изменяется через каждую половину периода.

Трансформаторы с минимальным и нормальным магнитным рассеянием

Трансформаторы СТЭ характеризуются тем, что их обмотка обладает минимальным магнитным рассеянием. При этом сила тока регулируется за счет винтового механизма дросселя, вынесенного отдельно.

Трансформаторы с нормальным магнитным рассеянием в чем-то схожи с предыдущими. Основное различие между ними заключается в том, что присутствует дополнительная реактивная катушка, которая находится на главных стержнях магнитного сердечника и обмотке дросселя. Дроссель устанавливают на магнитный сердечник, при этом сила тока регулируется точно таким же образом, что и при работе с трансформатором СТЭ.

Трансформаторы с повышенным магнитным рассеянием

Главное отличие трансформаторов с повышенным магнитным рассеянием от трансформаторов с низким и нормальным рассеянием заключается в наличии подвижной конструкции шунтов и обмоток. Благодаря такому подходу можно получить более высокие рабочие характеристики независимо от массы самого трансформатора.

Благодаря такому подходу можно получить более высокие рабочие характеристики независимо от массы самого трансформатора.

Среди трансформаторов с повышенным магнитным рассеянием можно найти модели с подвижными обмотками, к примеру, трансформаторы ТСК-300, ТД-300, ТС-500. Кроме этого, существуют модели, у которых имеются подвижные магнитные шунты (ТДМ-317 и СТШ-250). Также можно отметить модели с неподвижными подмагничивающими шунтами и обмотками (ТДФ-2001 и ТДФ-1001) и конструкции со сложной магнитной коммутацией (ВД-306 и ВДУ-506). На сегодняшний день чаще всего используются модели трансформаторов ТД и ТС, а также их модификации ТДЭ и ТДМ.

Тиристорные трансформаторы

Также стоит отметить тиристорные трансформаторы, работа которого основана фазовом регулировании силы тока за счет тиристоров, которые осуществляют преобразование поступающего переменного тока в знакопеременные импульсы. Сначала такие трансформаторы, из-за нестабильности горения дуги, применялись исключительно при контактной и шлаковой сварке. Однако, по мере развития полупроводниковых технологий тиристорные сварочные трансформаторы претерпели определенные изменения и стали одними из лучших аппаратов, которые отлично подходят не только для шлаковой и точечной сварок, но и ручной дуговой.

Однако, по мере развития полупроводниковых технологий тиристорные сварочные трансформаторы претерпели определенные изменения и стали одними из лучших аппаратов, которые отлично подходят не только для шлаковой и точечной сварок, но и ручной дуговой.

| Город |

Регион/Область |

Срок доставки |

|---|---|---|

| Майкоп | Республика Адыгея | 3-4 дней |

| Уфа | Республика Башкортостан | 1-3 дней |

| Улан-Удэ | Республика Бурятия | 5-15 дней |

| Горно-Алтайск | Республика Алтай | 1-2 дней |

| Минск — Козлова | Минск | 1-2 дней |

| Назрань | Республика Ингушетия | 1-2 дней |

| Нальчик | Кабардино-Балкарская Республика | 1-2 дней |

| Элиста | Республика Калмыкия | 1-2 дней |

| Черкесск | Республика Карачаево-Черкессия | 1-2 дней |

| Петрозаводск | Республика Карелия | 1-2 дней |

| Сыктывкар | Республика Коми | 1-2 дней |

| Йошкар-Ола | Республика Марий Эл | 1-2 дней |

| Саранск | Республика Мордовия | 1-2 дней |

| Якутск | Республика Саха (Якутия) | 1-2 дней |

| Владикавказ | Республика Северная Осетия-Алания | 1-2 дней |

| Казань | Республика Татарстан | 5-7 дней |

| Кызыл | Республика Тыва | 5-7 дней |

| Ижевск | Удмуртская Республика | 5-7 дней |

| Абакан | Республика Хакасия | 5-7 дней |

| Чебоксары | Чувашская Республика | 5-7 дней |

| Барнаул | Алтайский край | 5-7 дней |

| Краснодар | Краснодарский край | 5-7 дней |

| Красноярск | Красноярский край | 5-7 дней |

| Владивосток | Приморский край | 5-7 дней |

| Ставрополь | Ставропольский край | 5-7 дней |

| Хабаровск | Хабаровский край | 7-12 дней |

| Благовещенск | Амурская область | 7-12 дней |

| Архангельск | Архангельская область | 7-12 дней |

| Астрахань | Астраханская область | 7-12 дней |

| Белгород | Белгородская область | 7-12 дней |

| Брянск | Брянская область | 7-12 дней |

| Владимир | Владимирская область | 7-12 дней |

| Волгоград | Волгоградская область | 7-12 дней |

| Вологда | Вологодская область | 7-12 дней |

| Воронеж | Воронежская область | 7-12 дней |

| Иваново | Ивановская область | 7-12 дней |

| Иркутск | Иркутская область | 7-12 дней |

| Калининград | Калиниградская область | 7-12 дней |

| Калуга | Калужская область | 4-7 дней |

| Петропавловск-Камчатский | Камчатская область | 4-7 дней |

| Кемерово | Кемеровская область | 4-7 дней |

| Киров | Кировская область | 4-7 дней |

| Кострома | Костромская область | 4-7 дней |

| Курган | Курганская область | 4-7 дней |

| Курск | Курская область | 1-3 дней |

| Санкт-Петербург | Ленинградская область | 1-3 дней |

| Липецк | Липецкая область | 1-3 дней |

| Магадан | Магаданская область | 1-3 дней |

| Москва | Московская область | 1-3 дней |

| Мурманск | Мурманская область | 1-3 дней |

| Нижний Новгород | Нижегородская область | 1-3 дней |

| Новгород | Новгородская область | 1-3 дней |

| Новосибирск | Новосибирская область | 1-3 дней |

| Омск | Омская область | 1-3 дней |

| Оренбург | Оренбургская область | 1-3 дней |

| Орел | Орловская область | 1-3 дней |

| Пенза | Пензенская область | 1-3 дней |

| Пермь | Пермская область | 1-3 дней |

| Псков | Псковская область | 1-3 дней |

| Ростов-на-Дону | Ростовская область | 1-3 дней |

| Рязань | Рязанская область | 1-3 дней |

| Самара | Самарская область | 1-3 дней |

| Саратов | Саратовская область | 1-3 дней |

| Южно-Сахалинск | Сахалинская область | 1-3 дней |

| Екатеринбург | Свердловская область | 1-3 дней |

| Смоленск | Смоленская область | 1-2 дней |

| Тамбов | Тамбовская область | 1-2 дней |

| Тверь | Тверская область | 1-2 дней |

| Томск | Томская область | 1-2 дней |

| Тула | Тульская область | 1-2 дней |

| Тюмень | Тюменская область | 1-2 дней |

| Ульяновск | Ульяновская область | 1-2 дней |

| Челябинск | Челябинская область | 1-2 дней |

| Чита | Читинская область | 1-2 дней |

| Ярославль | Ярославская область | 1-2 дней |

| Москва | г. | 1-2 дней |

| Санкт-Петербург | г. Санкт-Петербург | 1-2 дней |

| Биробиджан | Еврейская автономная область | 1-2 дней |

| пгт Агинское | Агинский Бурятский авт. округ | 1-2 дней |

| Кудымкар | Коми-Пермяцкий автономный округ | 1-2 дней |

| пгт Палана | Корякский автономный округ | 1-2 дней |

| Нарьян-Мар | Ненецкий автономный округ | 1-2 дней |

| Дудинка | Таймырский (Долгано-Ненецкий) автономный округ | 1-2 дней |

| пгт Усть-Ордынский | Усть-Ордынский Бурятский автономный округ | 1-2 дней |

| Ханты-Мансийск | Ханты-Мансийский автономный округ | 1-2 дней |

| Анадырь | Чукотский автономный округ | 1-2 дней |

| пгт Тура | Эвенкийский автономный округ | 1-2 дней |

| Салехард | Ямало-Ненецкий автономный округ | 1-2 дней |

| Грозный | Чеченская Республика | 1-2 дней |

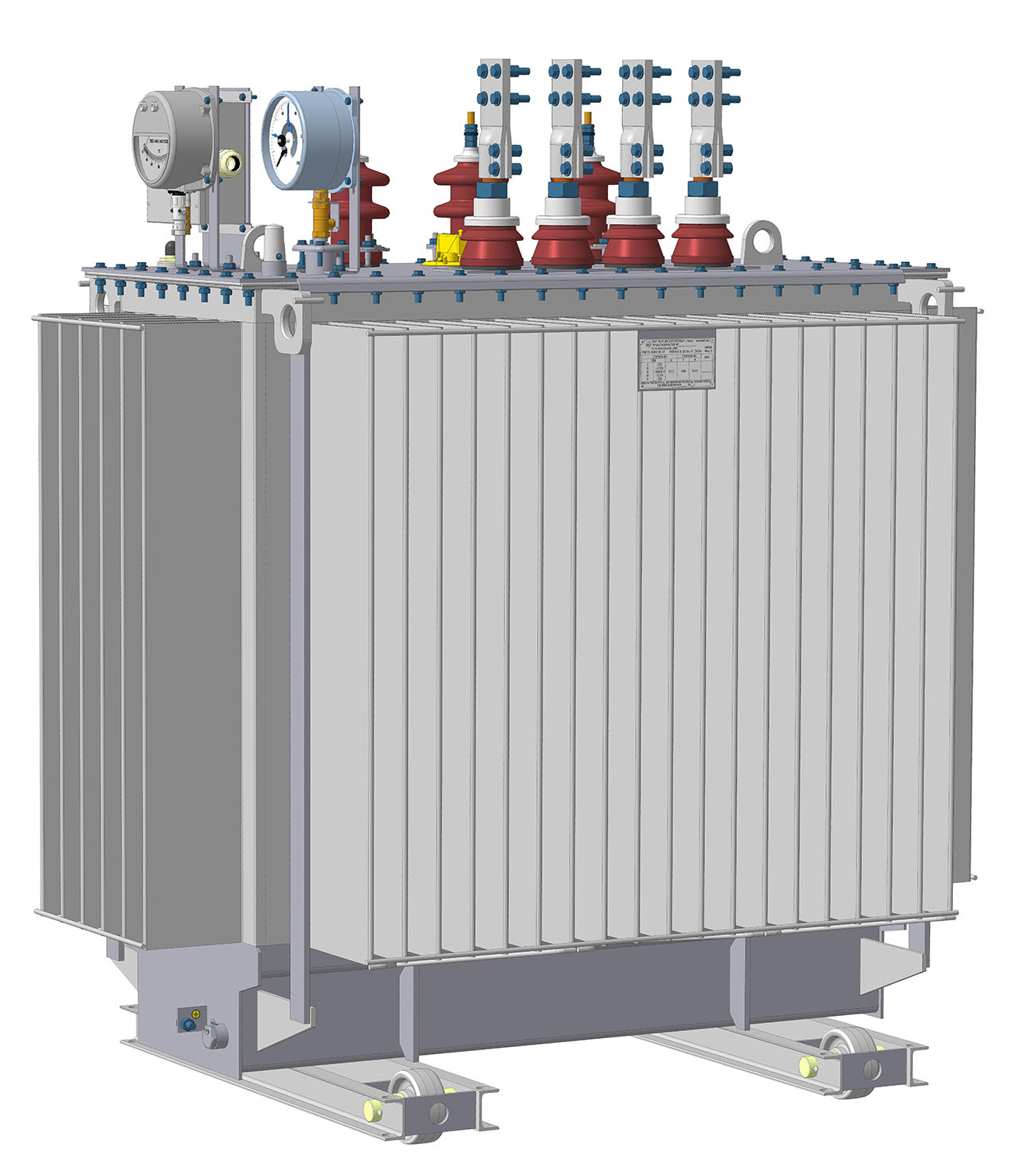

Трансформатор ТМФ 400/10/0,4

Разместить заказ на трансформаторы ТМФ 400/10/0,4 или ТМГФ 400/10/0,4

Трансформатор ТМФ/ТМГФ производится только прямоугольной формы. Отличается от других типов трансформаторов расположением вводов ВН и НН по бокам слева или справа. Возможно исполнение вводов сверху на крышке бака или сбоку — по фланцам трансформатора.

Отличается от других типов трансформаторов расположением вводов ВН и НН по бокам слева или справа. Возможно исполнение вводов сверху на крышке бака или сбоку — по фланцам трансформатора.

По требованию заказчика возможно изготовление ТМФ/ТМГФ на салазках

Температурные изменения объема масла компенсируются маслорасширителем. Встроенный воздухоосушитель, предотвращают попадание в трансформатор влаги и промышленных загрязнений.

Для измерения температуры верхнего уровня масла в баке устанавливаются термометрические датчики, которые контролируют внутреннее давление и сигнализируют о предельно допустимых величинах давления.

Для установки в условиях тропического климата используются только медные обмотки.

Диапазон мощности трансформатора ТМФ/ТМГФ — 160-2500 кВА

- Номинальное напряжение первичной обмотки ВН-6; 10 кВ

- Регулирование напряжения ПБВ со стороны ВН — ±2×2,5%

- Климатическое исполнение — У1, УЗ, УХЛ1

- Схема соединения — У/Ун-0 (звезда-звезда), Д/Ун-11 (треугольник-звезда)

Трансформаторы силовые трехфазные двухобмоточные с расширителем с естественным охлаждением масла. Маслорасширитель, установленный на крышке бака, имеет вентиляционное отверстие, соединенное через воздухосушитель. Давление масла в трансформаторе остается постоянным и не зависит от температуры. По заказу потребителя трансформатор может быть изготовлен с радиаторным или гофрированным баком

Маслорасширитель, установленный на крышке бака, имеет вентиляционное отверстие, соединенное через воздухосушитель. Давление масла в трансформаторе остается постоянным и не зависит от температуры. По заказу потребителя трансформатор может быть изготовлен с радиаторным или гофрированным баком

Трансформатор масляный ТМ с естественным воздушным охлаждением предназначен для преобразования электрической энергии одного напряжения в электрическую энергию другого напряжения. Регулирование напряжения трансформатора ТМ осуществляется в диапазоне до ± 5 % на полностью отключенном трансформаторе (ПБВ) переключением ответвлений обмотки ВН ступенями по 2,5 %.

ТМ cостоит из активной части, крышки и сварного бака овальной формы. На крышке расположены вводы ВН и НН, привод переключателя, расширитель с маслоуказателем и воздухоосушителем.

Активная часть масляного трансформатора ТМФ/ТМГФ состоит из магнитопровода с обмотками, нижних и верхних ярмовых балок. Трансформатор помещен в бак с маслом для охлаждения и предотвращения разрушение обмоток трансформатора от внешней среды.

Обмотки ТМ сделаны из алюминиевых обмоточных проводов, межслойная изоляция – из кабельной бумаги.

СТРУКТУРА УСЛОВНОГО ОБОЗНАЧЕНИЯ ТМ(Г)Ф-Х/10(6)-У1

Т — Трансформатор трехфазный

М — МасляныйТ

Г -Герметичный

Ф -Фланцевый

X — Номинальная мощность, кВА

У1 — Климатическое исполнение и категория

размещения по ГОСТ 15150

Условия эксплуатации трансформатора ТМ(Г)Ф

- Окружающая среда не взрывоопасная, не содержащая токопроводящей пыли;

- Высота установки над уровнем моря не более 1000 м;

- Режим работы длительный;

- Температура окружающей среды от -60°С до +40°С;

- Трансформаторы не предназначены для работы в условиях тряски, вибраций, ударов, в химически агрессивной среде.

Скачать опросный лист на трансформатор ТМ(Г)Ф

Сварочный трансформатор — 105 фото разновидностей трансформаторных аппаратов

В наше время сварочное дело перестало быть уделом избранных. Сейчас сварочное оборудование можно встретить не только на производстве, но и в дачных домовладениях. Самыми популярными считаются трансформаторные аппараты переменного тока.

Сейчас сварочное оборудование можно встретить не только на производстве, но и в дачных домовладениях. Самыми популярными считаются трансформаторные аппараты переменного тока.

Краткое содержимое статьи:

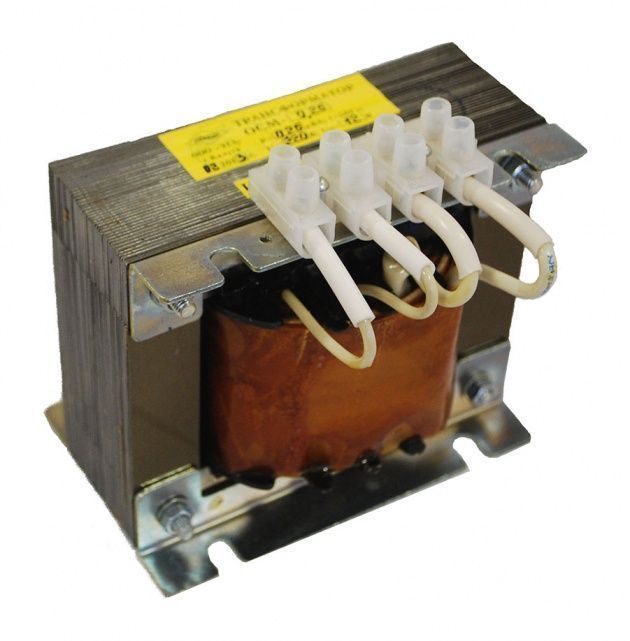

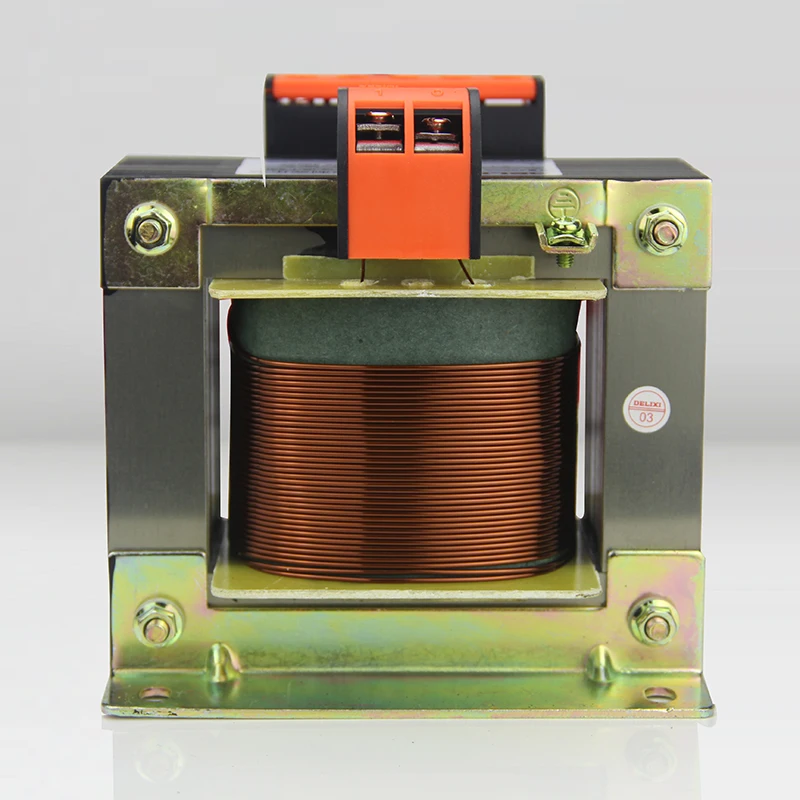

Конструкционное решение трансформаторного оборудования

Устройство сварочного трансформатора достаточно простое – это пара обмоток, намотанных на сердечник. Одна из них первичная, а вторая – вторичная.

Принцип работы аппарата трансформаторного типа состоит в понижении входящего напряжения. Сила тока при этом может составлять порядка 700А, что позволяет осуществлять сварку металлических конструкций. Такой принцип действия характерен для всех разновидностей трансформаторного оборудования.

Хотя сегодня, при использовании современных разработок и технологий удалось добиться создания более идеальных и эргономичных вариаций трансформаторов.

Разновидности трансформаторных аппаратов

Все сварочные трансформаторы принято делить на три вида, у каждого из которых свои сильные и слабые стороны. Выбирая аппарат для сварки трансформаторного типа, нужно знать, чем одна разновидность отличается от другой.

Выбирая аппарат для сварки трансформаторного типа, нужно знать, чем одна разновидность отличается от другой.

Как показывают фото сварочных трансформаторов, они могут быть:

- С минимальным и нормальным магнитным рассеиванием.

- С повышенным магнитным рассеиванием.

- Тиристорными.

Технические характеристики

Независимо от типа для каждого трансформатора характерен набор конкретных характеристик, определяющих эффективность и качество его работы, а также удобство эксплуатации. Выбирая агрегат, нужно знать, что означает каждая характеристика сварочного трансформатора.

Маркировка. Это первое, на что надо обратить внимание. Маркировка – это зашифрованная запись базовых параметров. Первая буква обозначает источник питания, вторая указывает на тип сварочных работ, а третья – на метод. Четвёртая и пятая – это тип внешней характеристики и число постов.

Значение номинальной силы электрического тока – это 1 или 2 цифры, округлённые до десятых или сотых. Два или одно последних цифровых обозначения – это регистрационный номер.

Два или одно последних цифровых обозначения – это регистрационный номер.

Далее буквами обозначается допустимые температурные условия. Цифра в конце указывает на уместное расположение. I- значит допустима работа устройства на улице, II – под навесом, III – в неотапливаемой комнате, IV – в помещении с отоплением.

Диапазон регулировки тока. Это одна из главных характеристик любого трансформаторного устройства. Первое, что она обозначает – это то, что регулирование тока возможно, а второе – это наибольшую возможную величину силы тока. Все вместе указывает на возможность применять электроды разных размеров.

Диаметр электрода. Зависит от силы тока оборудования.

Напряжение в электросети. Данная характеристика показывает, какое напряжение обязано быть в сети, чтобы трансформатор нормально работал.

Номинальный ток сварки и рабочее напряжение. Эти параметры очень важны. Номинальный ток – это наибольший показатель тока, который может выдать агрегат. А номинальное напряжение – напряжение, требуемое для того, чтобы сварочная дуга была в устойчивом состоянии.

А номинальное напряжение – напряжение, требуемое для того, чтобы сварочная дуга была в устойчивом состоянии.

Продолжительность включения. Это время, которое аппарат трансформаторного типа может находиться в режиме сварки. Данный показатель не оказывает особого влияния на выбор сварочного оборудования.

Потребляемая мощность. Обозначает количество энергии, требуемой для 1 часа работы агрегата. Предпочтительнее остановить выбор на устройстве с минимальным параметром мощности потребления.

КПД. Чем больше данное значение, тем лучше.

Напряжение холостого хода. Оно отвечает за сварочную дугу. Чем оно выше, тем проще создаётся дуга.

Число рабочих мест. Это число человек, которые могут одновременно заниматься сваркой от данного устройства.

Система охлаждения.

Вес и габариты сварочного аппарата.

Начинающему малоопытному сварщику достаточно непросто выбрать подходящую модель сварочного трансформатора, ведь типов аппаратов для сварки довольно много. Поэтому, чтобы сделать правильный выбор, важно знать значение каждой технической характеристики. Если у вас возникли трудности, то лучше обратиться за советом к профессионалу.

Поэтому, чтобы сделать правильный выбор, важно знать значение каждой технической характеристики. Если у вас возникли трудности, то лучше обратиться за советом к профессионалу.

Фото сварочного трансформатора

Также рекомендуем посетить:

Сварочный трансформатор ЗУБР ЗТС-250 — доступная цена, отзывы, описания и характеристики, фото

Сварочный трансформатор ЗУБР ЗТС-250 — мощный агрегат с энергопотреблением 11.2 кВт. Подходит для бытового и профессионального применения — в автогаражной, строительной, коммунальной сферах. Осуществляет сварку сталей методом ММА (ручная дуговая). Работает на переменном токе с электродами диаметром — от 2 до 5 мм, выдавая силу тока — от 60 до 250 Ампер.

Осуществляет сварку сталей методом ММА (ручная дуговая). Работает на переменном токе с электродами диаметром — от 2 до 5 мм, выдавая силу тока — от 60 до 250 Ампер.

- Напряжение, В 220/380

- Max мощность, кВт 11,2

- Max ток, А 250

- Min ток, А 60

- Диаметр электр/провол, мм 2.000-5.000

- ПВ на максимальном токе, % 10

- org/PropertyValue»> Количество постов 1

- Степень защиты IP21

- Наличие сетевой вилки нет

- Вес, кг 21,5

- Класс товара Бытовой

- Напряжение холостого хода, В 48

- Показать еще

Комплектация *

- Комплект проводов;

- Маска сварщика;

- Щётка шлакоотбойник;

- Колеса — 2 шт;

- Рукоятка.

Параметры упакованного товара

Единица товара: Штука

Вес, кг: 23,60

Длина, мм: 395

Ширина, мм: 510

Высота, мм: 320

Особенности трансформатора ЗУБР ЗТС-250

| ||||||

Преимущества

|

Произведено

- Россия — родина бренда

- Китай — страна производства*

- Информация о производителе

Указанная информация не является публичной офертой

На данный момент для этого товара нет расходных материаловСервис от ВсеИнструменты.

ру

ру Мы предлагаем уникальный сервис по обмену, возврату и ремонту товара!

Средний срок ремонта для данной модели составляет 35 дней

Обратиться по обмену, возврату или сдать инструмент в ремонт вы можете в любом магазине или ПВЗ ВсеИнструменты.ру.

Гарантия производителя

Гарантия производителя 5 летГарантийный ремонт

Здесь вы найдете адреса расположенных в вашем городе лицензированных сервисных центров.

| Лицензированные сервисные центры | Адрес | Контакты |

|---|---|---|

| СЦ «Зубр» МСК Средний срок ремонта — 14 дней | ул. Библиотечный пр-д, д. 1А | +7 (495) 730-34-00 |

МосСтройПрокат аренда инструмента в Москве

Скорость процесса гидратации, в результате которого происходит твердение бетонного раствора, зависит от нескольких факторов.

Одним из главных условий схватывания смеси является поддерживание температуры на заданном уровне.

Уменьшение сроков затвердения бетонного монолита находится в прямой зависимости от температуры.

При температуре воздуха ниже 20°C бетон твердеет примерно месяц.

Нагретый до 25-30°C бетонный раствор схватывается за 7 дней.

Если нагреть изделие до 40-50°C, время, необходимое на затвердевание бетона, сокращается до 16-20 часов.

Затраты на нагрев бетона на каждые 10°C окупятся сокращением сроков строительства.

Очевидно, то аренда трансформатора прогрева бетона – это разумное решение.

Следует помнить, что в погоне за скоростью раствор не следует перегревать.

При температуре порядка 90°C вода усиленно испаряется, и бетонная смесь высыхает, не успев набрать марочную прочность.

Что следует учесть при выборе трансформатора прогрева бетона

Агрегаты данного типа делятся на аппараты с воздушным и масляным охлаждением.

Первые также подразделяются на трансформаторы с естественной и принудительной циркуляцией воздуха.

Масляное охлаждение действует более эффективно, но имеет большие габариты и значительно утяжеляет конструкцию.

Приобретая в аренду трансформатора прогрева бетона с масляным охлаждением, следует подумать о том, что для перемещения данного агрегата понадобится кран-манипулятор или другое грузоподъемное оборудование.

Следующая градация – максимальная мощность.

Чтобы правильно выбрать трансформатор прогрева бетона, требуется учесть площадь и объем заливаемого бетона.

Также имеет значение степень утепления изделия и температура воздуха.

Рассчитывать необходимую мощность должен специалист, имеющий профильное образование и достаточный опыт в данной сфере.

Если к срокам не предъявляется серьезных требований, и трансформатор арендуется для того, чтобы просто предотвратить замерзание свежеуложенного бетона, можно сделать небольшие допуски.

Примерные параметры можно рассчитать по простой закономерности: один киловатт мощности трансформатора способен прогревать 0,8 м2 бетонной смеси.

Снижение температуры затвердевшего прогретого бетона требуется снижать плавно.

Если просто отключить трансформатор после схватывания смеси, в изделии образуются температурные напряжения.

Данное явление вызвано физическими процессами: верхний слой охлаждается быстрее, его линейные размеры уменьшаются, внутренняя же часть монолита остается теплой и не сжимается.

Возрастающие напряжения приводят к разрушению структуры бетона.

Трансформаторы для светодиодных ламп и гирлянд на 12-24 вольта на VipNeon.ru

Зачем нужен силовой понижающий трансформатор

Актуальные сегодня источники света, светодиоды, нашли применение во многих отраслях и сферах человеческой жизни. Одной из таких сфер является декорирование помещений, зданий, площадей, а также сфера рекламы. Одна из отличительных особенностей светодиодного освещения – низкий уровень энергопотребления. Таким образом, технические характеристики диктуют некоторые условия применения – обязательным, в большинстве случаев, является использование понижающего трансформатора. Так, трансформатор для неона купить не менее важно, чем комплект коннекторов для его подключения.

Так, трансформатор для неона купить не менее важно, чем комплект коннекторов для его подключения.

Кроме того, конструкция многих устройств предполагает возможность создания светодинамических эффектов. Впрочем, наличие или отсутствие этой возможности напрямую связано с использованием контроллера.

Ассортимент светодиодных устройств впечатляет: это и LED дюралайт, и светодиодные гирлянды, и световые фигуры, панно, объемные фигуры и т.д. Многие из перечисленных используются как внутри, так и снаружи помещения, для оформления частного жилья и общественных объектов. Особо стоит отметить тот факт, что светодиодная подсветка, используемая вне помещения и работающая в постоянном режиме, нуждается в стабильном напряжении электрического тока.

Самый популярный трансформатор для светодиодной ленты — 12 вольт

Наиболее востребованными трансформаторами понижения напряжения, применительно к светодиодным изделиям, являются устройства, снижающие показатель напряжения с 220В до 12 или 24В. Мощность подобных трансформаторов составляет от 1 до 800Вт. К примеру, купить трансформатор для светодиодной ленты 12 Вольт – 220 Вольт в интернет-магазине VipNeon означает не только создать эффектную контурную подсветку, а и сделать выгодное приобретение качественных комплектующих. А трансформаторы для светодиодных лент на 12 Вольт, цена которых вписывается в любой бюджет, широко представлены в нашем каталоге.

Мощность подобных трансформаторов составляет от 1 до 800Вт. К примеру, купить трансформатор для светодиодной ленты 12 Вольт – 220 Вольт в интернет-магазине VipNeon означает не только создать эффектную контурную подсветку, а и сделать выгодное приобретение качественных комплектующих. А трансформаторы для светодиодных лент на 12 Вольт, цена которых вписывается в любой бюджет, широко представлены в нашем каталоге.

Трансформаторы для светодиодных лент 12 вольт цена

Представленные в данной категории трансформаторы гарантируют постоянное и равномерное напряжение тока на выходе, благодаря чему светодиодные устройства обеспечат однородное, ровное и стабильное свечение. На практике использование такого трансформатора способно исключить мерцание источника света, незаданное контроллером.

Какой трансформатор для неона купить

Трансформаторы, представленные в категории, надежно защищены от воздействия внешних факторов физического происхождения: влага, пыль, ветер, перепад температуры. Эта черта является обязательным свойством, учитывая, что светодиодные устройства очень часто используется для декорирования снаружи помещений.

Эта черта является обязательным свойством, учитывая, что светодиодные устройства очень часто используется для декорирования снаружи помещений.

Что же касается контроллеров, то эти приспособления сегодня являются незаменимым атрибутом праздничных светодиодных декораций – они обеспечивают волшебное мерцание, задать ритм светодинамики в соответствии с используемым музыкальным сопровождением. С контроллером мерцание диодов в такт «В лесу родилась елочка» становится впечатляющей реальностью.

На нашем сайте Вы найдете трансформаторы и контроллеры, идеально подходящие для представленных светодиодных устройств. Создание эффектной декорации не отнимет много времени – достаточно соблюдать требования, указанные в характеристиках светодиодного изделия. Правильно подобранный комплект оборудования позволит обеспечить стабильную, безопасную и броскую работу собранной композиции.

Как выбрать силовой понижающий трансформатор

Компетентная помощь консультанта исключит сложности в выборе, будь то трансформатор для светодиодной ленты 12 вольт или контроллер для холодного неона. Все, что вам необходимо – наверняка знать, к какому именно светодиодному устройству необходимо подобрать устройства. Удобный каталог и детальная информация помогут быстрее сориентироваться и с максимальной выгодой купить трансформатор для светодиодной ленты и комплект подключения, контроллер для LED конструкций или любой силовой понижающий трансформатор, разработанный для использования на улице.

Все, что вам необходимо – наверняка знать, к какому именно светодиодному устройству необходимо подобрать устройства. Удобный каталог и детальная информация помогут быстрее сориентироваться и с максимальной выгодой купить трансформатор для светодиодной ленты и комплект подключения, контроллер для LED конструкций или любой силовой понижающий трансформатор, разработанный для использования на улице.

трансформаторов для распознавания изображений в масштабе

Автор: Нил Хоулсби и Дирк Вайссенборн, ученые-исследователи, Google Research

Хотя сверточные нейронные сети (CNN) использовались в компьютерном зрении с 1980-х годов, они не были на переднем крае до 2012 года, когда AlexNet с большим отрывом превзошел по производительности современные современные методы распознавания изображений. Два фактора помогли сделать этот прорыв: (i) доступность обучающих наборов, таких как ImageNet, и (ii) использование массового оборудования GPU, которое обеспечило значительно больше вычислений для обучения. Таким образом, с 2012 года CNN стали образцом для решения задач видения.

Таким образом, с 2012 года CNN стали образцом для решения задач видения.

Преимущество использования CNN состояло в том, что они избегали необходимости создавать визуальные элементы, разработанные вручную, вместо этого они учились выполнять задачи напрямую от данных «от начала до конца». Однако, хотя CNN избегают ручного извлечения признаков, сама архитектура разработана специально для изображений и может потребовать вычислительных ресурсов. С нетерпением ожидая следующего поколения масштабируемых моделей видения, можно спросить, необходим ли этот предметно-ориентированный дизайн, или можно было бы успешно использовать более независимые от предметной области и вычислительно эффективные архитектуры для достижения современных результатов.

В качестве первого шага в этом направлении мы представляем Vision Transformer (ViT), модель технического зрения, максимально основанную на архитектуре Transformer, изначально разработанной для текстовых задач. ViT представляет входное изображение как последовательность фрагментов изображения, аналогичную последовательности вложений слов, используемых при применении преобразователей к тексту, и напрямую предсказывает метки классов для изображения. ViT демонстрирует отличную производительность при обучении на достаточном количестве данных, превосходя сопоставимые современные CNN с в четыре раза меньшими вычислительными ресурсами.Чтобы способствовать дополнительным исследованиям в этой области, мы открыли исходный код как кода, так и моделей.

ViT демонстрирует отличную производительность при обучении на достаточном количестве данных, превосходя сопоставимые современные CNN с в четыре раза меньшими вычислительными ресурсами.Чтобы способствовать дополнительным исследованиям в этой области, мы открыли исходный код как кода, так и моделей.

| Vision Transformer обрабатывает входное изображение как последовательность патчей, сродни серии встраиваний слов, генерируемых преобразователем обработки естественного языка (NLP). |

The Vision Transformer

Исходный текст Transformer принимает в качестве входных данных последовательность слов, которые затем используются для классификации, перевода или других задач НЛП.Что касается ViT, мы вносим минимально возможные изменения в конструкцию Transformer, чтобы заставить его работать непосредственно с изображениями, а не со словами, и наблюдаем, сколько информации о структуре изображений модель может узнать сама по себе.

ViT разделяет изображение на сетку квадратных участков. Каждый патч сглаживается в один вектор путем объединения каналов всех пикселей в патче и затем линейного проецирования его на желаемое входное измерение. Поскольку трансформеры не зависят от структуры входных элементов, мы добавляем обучаемые вложения позиций в каждый патч, что позволяет модели узнавать о структуре изображений. Априори , ViT не знает об относительном расположении пятен на изображении или даже о том, что изображение имеет двумерную структуру — он должен узнать такую релевантную информацию из обучающих данных и кодировать структурную информацию во вложенных позициях.

Масштабирование

Сначала мы обучаем ViT в ImageNet, где он достигает максимальной точности 77,9%. Хотя это прилично для первой попытки, оно далеко отстает от современных достижений — текущий лучший CNN, обученный на ImageNet без дополнительных данных, достигает 85.8%. Несмотря на стратегии смягчения (например, регуляризацию), ViT превосходит задачу ImageNet из-за отсутствия встроенных знаний об изображениях.

Чтобы исследовать влияние размера набора данных на производительность модели, мы обучаем ViT на ImageNet-21k (14M изображений, 21k классов) и JFT (300M изображений, 18k классов) и сравниваем результаты с современной CNN, Big Transfer (BiT), обученный на тех же наборах данных. Как уже отмечалось ранее, ViT работает значительно хуже, чем эквивалент CNN (BiT) при обучении в ImageNet (1M изображений).Однако на ImageNet-21k (14M изображений) производительность сопоставима, а на JFT (300M изображений) ViT теперь превосходит BiT.

Наконец, мы исследуем влияние объема вычислений, участвующих в обучении моделей. Для этого мы обучаем несколько различных моделей ViT и CNN на JFT. Эти модели охватывают диапазон размеров моделей и продолжительности обучения. В результате для обучения им требуется разное количество вычислений. Мы видим, что при заданном объеме вычислений ViT дает лучшую производительность, чем эквивалентные CNN.

Слева: Производительность ViT при предварительном обучении на разных наборах данных. Справа: ViT дает хороший компромисс между производительностью и вычислительными ресурсами. Справа: ViT дает хороший компромисс между производительностью и вычислительными ресурсами. |

Высокопроизводительное распознавание крупномасштабных изображений

Наши данные показывают, что (1) при достаточном обучении ViT может работать очень хорошо, и (2) ViT дает отличный компромисс между производительностью и вычислительными ресурсами как в меньших, так и в больших масштабах вычислений. Поэтому, чтобы увидеть, распространятся ли улучшения производительности на еще большие масштабы, мы обучили модель ViT с 600M параметрами.

Эта большая модель ViT демонстрирует высочайшую производительность по нескольким популярным тестам, включая точность 88,55% на первом этапе в ImageNet и 99,50% на CIFAR-10. ViT также хорошо работает с очищенной версией набора оценок ImageNet «ImageNet-Real», достигая точности 90,72% наивысшего уровня. Наконец, ViT хорошо работает с разнообразными задачами, даже с небольшим количеством обучающих данных. Например, в пакете VTAB-1k (19 задач с 1000 точками данных каждая) ViT достигает 77,63%, что значительно опережает современное состояние с одной моделью (SOTA) (76.3%), и даже соответствие SOTA, полученное ансамблем нескольких моделей (77,6%). Что наиболее важно, эти результаты получены с использованием меньшего количества вычислительных ресурсов по сравнению с предыдущими SOTA CNN, например, в 4 раза меньше, чем предварительно обученные модели BiT.

Например, в пакете VTAB-1k (19 задач с 1000 точками данных каждая) ViT достигает 77,63%, что значительно опережает современное состояние с одной моделью (SOTA) (76.3%), и даже соответствие SOTA, полученное ансамблем нескольких моделей (77,6%). Что наиболее важно, эти результаты получены с использованием меньшего количества вычислительных ресурсов по сравнению с предыдущими SOTA CNN, например, в 4 раза меньше, чем предварительно обученные модели BiT.

| Vision Transformer соответствует или превосходит современные CNN по популярным тестам. Слева: Популярные задачи классификации изображений (ImageNet, включая новые проверочные метки ReaL и CIFAR, Pets и Flowers). Справа: Среднее значение по 19 задачам из набора классификации VTAB. |

Визуализации

Чтобы получить некоторое представление о том, что модель изучает, мы визуализируем некоторые из ее внутренних работ. Во-первых, мы смотрим на вложения позиций — параметры, которые модель учится кодировать относительное расположение пятен — и обнаруживаем, что ViT может воспроизводить интуитивно понятную структуру изображения. Встраивание каждой позиции наиболее похоже на другие в той же строке и столбце, что указывает на то, что модель восстановила сеточную структуру исходных изображений.Во-вторых, мы исследуем среднее пространственное расстояние между одним элементом и другим для каждого блока трансформатора. На более высоких уровнях (глубины 10-20) используются только глобальные особенности (т. Е. Большие расстояния внимания), но нижние слои (глубины 0-5) захватывают как глобальные, так и локальные особенности, на что указывает большой диапазон среднего внимания. расстояние. Напротив, в нижних слоях CNN присутствуют только локальные особенности. Эти эксперименты показывают, что ViT может изучать функции, жестко закодированные в CNN (например, осведомленность о структуре сетки), но также может свободно изучать более общие шаблоны, такие как сочетание локальных и глобальных функций на более низких уровнях, которые могут помочь в обобщении.

Во-первых, мы смотрим на вложения позиций — параметры, которые модель учится кодировать относительное расположение пятен — и обнаруживаем, что ViT может воспроизводить интуитивно понятную структуру изображения. Встраивание каждой позиции наиболее похоже на другие в той же строке и столбце, что указывает на то, что модель восстановила сеточную структуру исходных изображений.Во-вторых, мы исследуем среднее пространственное расстояние между одним элементом и другим для каждого блока трансформатора. На более высоких уровнях (глубины 10-20) используются только глобальные особенности (т. Е. Большие расстояния внимания), но нижние слои (глубины 0-5) захватывают как глобальные, так и локальные особенности, на что указывает большой диапазон среднего внимания. расстояние. Напротив, в нижних слоях CNN присутствуют только локальные особенности. Эти эксперименты показывают, что ViT может изучать функции, жестко закодированные в CNN (например, осведомленность о структуре сетки), но также может свободно изучать более общие шаблоны, такие как сочетание локальных и глобальных функций на более низких уровнях, которые могут помочь в обобщении.

| Слева: ViT изучает сетчатую структуру фрагментов изображения посредством встраивания своих позиций. Справа: Нижние уровни ViT содержат как глобальные, так и локальные функции, более высокие уровни содержат только глобальные функции. |

Резюме

Хотя CNN произвели революцию в компьютерном зрении, наши результаты показывают, что модели, специально разработанные для задач визуализации, могут быть ненужными или даже неоптимальными.В связи с постоянно увеличивающимися размерами наборов данных и продолжающейся разработкой неконтролируемых и частично контролируемых методов разработка новых архитектур машинного зрения, которые более эффективно обучаются на этих наборах данных, становится все более важной. Мы считаем, что ViT — это предварительный шаг к универсальным масштабируемым архитектурам, которые могут решать многие задачи видения или даже задачи из многих областей, и с нетерпением ждем будущих разработок.

Препринт нашей работы, а также код и модели находятся в открытом доступе.

Благодарности

Мы хотели бы поблагодарить наших соавторов в Берлине, Цюрихе и Амстердаме: Алексея Досовицкого, Лукаса Бейера, Александра Колесникова, Сяохуа Чжая, Томаса Унтертинера, Мостафу Дехгани, Матиаса Миндерера, Георга Хейгольда, Сильвен Гелли и Якоб Ушкорит. Мы хотели бы поблагодарить Андреаса Штайнера за решающую помощь с инфраструктурой и открытым исходным кодом, Джоан Пучсервер и Максима Ноймана за работу над крупномасштабной учебной инфраструктурой, а также Дмитрия Лепихина, Аравинда Махендрана, Даниэля Кейзера, Марио Лучича, Ноама Шазира и Колина Раффеля. за полезные обсуждения.Наконец, мы благодарим Тома Смолла за создание анимации Visual Transformer в этом посте.

ONE: Уникальные изображения на основе фотографий — Трансформаторная подстанцияТрансформаторная подстанция

Пятница, 18 сентября 2020 г. — воскресенье, 31 января 2021 г.

РАСШИРЕННЫЕ ДАТЫ, теперь доступны для просмотра до воскресенья, 31 января 2021 г.

Нажмите здесь чтобы зарезервировать БЕСПЛАТНЫЙ входной билет!

ONE: Уникальные фотообъекты

Эта выставка уникальных фотообъектов основана в основном на работах из коллекции Фреда и Лоры Рут Бидуэлл.Хотя среда фотографии характеризуется своей способностью воспроизводить несколько изображений одного и того же изображения, художники в ONE все манипулировали или искажали среду для создания уникальных предметов ручной работы. Многие работы в ONE напоминают живопись или ремесло и исследуют идеи, выходящие за рамки традиционных ролей и функций фотографического изображения.

Пока мы временно закрыты для публики, просмотрите эти интервью с художниками на выставке ниже:

Работы Криса МакКо , Джозеф Майнек и Кристофер Рассел используют процессы и инструменты, которые изначально были разработаны для объективного представления, в качестве средств для создания личных и эмоциональных жестов, раскрывающих процесс ручной работы для зрителя.Крис Маккоу раскрывает жестокость западного солнца, чтобы выжег его путь по небу радикально переэкспонированных ландшафтов. В абстрактном экспрессионистском свитке Мэрайи Робертсон разворачивается абстрактная картина длиной 130 дюймов в ядовитой цветовой фотохимии. Джозеф Минек создает строго дисциплинированные абстракции, заменяя инструкции производителя своими собственными процессами. Кристофер Рассел вписывает поверхность цветных абстракций с помощью фигуративных офортов, меняя традиционные роли фотографии и рисунка.

Фотографы всегда выборочно раскрывали или скрывали наш мир, помещая рамку вокруг своего поля зрения. Кайл Мейер и Уилмер Уилсон IV фокусируются на поверхности изображения, а не на его краях, как способ редактирования нашего обзора. Портреты Мейерса людей из сообщества ЛГБТК в Свазиленде отражают их индивидуальность и культуру, защищая при этом их идентичность, ткая тканевые реквизиты, используемые в их портретах, вместе с фотопечатью, чтобы создать новую «ткань». Уилсон увеличивает найденные листовки из районов Вашингтона, округ Колумбия.C. и репостит их, покрытые завитками скоб, затемняя и обнажая изображения внизу и превращая их в бюллетени как свободы, так и угнетения.

Кайл Мейер и Уилмер Уилсон IV фокусируются на поверхности изображения, а не на его краях, как способ редактирования нашего обзора. Портреты Мейерса людей из сообщества ЛГБТК в Свазиленде отражают их индивидуальность и культуру, защищая при этом их идентичность, ткая тканевые реквизиты, используемые в их портретах, вместе с фотопечатью, чтобы создать новую «ткань». Уилсон увеличивает найденные листовки из районов Вашингтона, округ Колумбия.C. и репостит их, покрытые завитками скоб, затемняя и обнажая изображения внизу и превращая их в бюллетени как свободы, так и угнетения.

Сэм Фоллс, Лиз Ридил, Лорен Дэвис и Нобутака Аозаки создают уникальные работы, которые расширяют границы фотографического изображения за пределы представления до концептуального. Фоллс бросает вызов стереотипам искусства, смешивая условности коммерческой «фотографии продукта» с печатью и живописью. Аозаки также использует язык коммерческой фотографии, чтобы проиллюстрировать найденные списки покупок таким образом, чтобы у зрителя был открытый и слегка вуайеристский взгляд на жизнь незнакомцев. Лорен Дэвис создает смесь между фотографируемым предметом и скульптурным объектом и усложняет отношения между реальным и искусственным. Фотобудка из мелкого магазина была использована Лиз Райдал для активации натюрмортов с тюльпанами, которые напоминают голландские натюрморты и модернистские сетки.

Лорен Дэвис создает смесь между фотографируемым предметом и скульптурным объектом и усложняет отношения между реальным и искусственным. Фотобудка из мелкого магазина была использована Лиз Райдал для активации натюрмортов с тюльпанами, которые напоминают голландские натюрморты и модернистские сетки.

В то время, когда многие художественные опыты были перенесены онлайн и на экран, все работы, представленные в ONE , прославляют важность физического объекта искусства, неся знаки и жесты руки и ума художника в Физический мир.

Параллельная выставка: Дэйв Джордано: (Человеческие) пейзажи

Эта выставка была организована Transformer Station при частичной поддержке жителей округа Кайахога за счет государственного гранта от Cuyahoga Arts & Culture.

Узнать больше о CAC

Проверка фактов: это фотография трансформатора в Уттар-Прадеше?

Претензия

Рейтинг

Описание

Фотография маленького трансформатора, подпираемого деревом, стала вирусной в социальных сетях с постоянным сообщением: «Если Керале нужно расти, BJP должна управлять ею — Йоги Адитья Натх (на фото: Трансформер в Уттар-Прадеше). ”

”

Координатор по ядерным вопросам Куданкулам С. П. Удаякумар опубликовал на своей странице в Facebook, что этим сообщением поделились более 13 000 человек. Этот пост с участием главного министра UP Йоги Адитьянатха и трансформера написан на другом языке. Читателей также спрашивают о его подлинности.

Проверка фактов:

Когда мы выполнили поиск обратного изображения фотографии Трансформера, которую широко критиковали как разработку штата Уттар-Прадеш, мы смогли увидеть сообщения, в которых использовалось одно и то же фото, утверждающее, что оно принадлежит другим штатам, включая Гуджарат.В 2020 году также был опубликован пост в Facebook, в котором утверждалось, что это Пакистан.

Фотография Трансформера, которая стала вирусной в социальных сетях и утверждала, что она находится в штатах Индия и Пакистан, не разглашается с какими-либо подробностями. Нет никаких новостей или свидетельств, подтверждающих, что этот трансформатор существует в Индии.

Поиск фотографии на обратном изображении и дальнейший поиск: «2 года назад эта фотография была опубликована на сайте pikabu.ru с информацией на русском языке. Перевести в Трансформатор в Республике Дагестан.«

Это фото трансформатора размещено на странице Hilvan Gölcük Village в Facebook в сентябре 2018 года в Турции.

Аналогичным образом, в октябре 2018 года фотография была размещена на веб-сайте iraqkhair со ссылкой на Ирак на арабском языке.

Однако 29 августа 2018 года сайт 06452.com сообщил, что «финансовый кризис в Луганской энергосистеме Украины ухудшается и вызывает серьезные отключения электроэнергии в некоторых городах, в том числе в Северодонецке.”

Заключение

В нашем поиске фото выкладывается как Transformer в состоянии UP некорректно. Нет никаких доказательств того, что фотография принадлежит Уттар-Прадеш. Ранее на этой же фотографии были опубликованы названия нескольких индийских штатов, в том числе Гуджарата.

Реклама

Также эта же фотография была размещена в пресс-релизе о влиянии электроснабжения на города Украины за последние 3 года. Фотография также путешествует по Ираку, Пакистану и Украине.

Реклама

Пробные ссылки

LMT Комплект светодиодного трансформатора низкого напряжения мощностью 12 Вт с фотоэлементом

Страна

США —————— AfghanistanAland IslandsAlbaniaAlgeriaAmerican SamoaAndorraAngolaAnguillaAntarcticaAntigua И BarbudaArgentinaArmeniaArubaAustraliaAustriaAzerbaijanBahamasBahrainBangladeshBarbadosBelarusBelgiumBelizeBeninBermudaBhutanBoliviaBosnia И HerzegovinaBotswanaBouvet IslandBrazilBritish Индийский океан TerritoryBrunei DarussalamBulgariaBurkina FasoBurundiCambodiaCameroonCanadaCape VerdeCayman IslandsCentral африканских RepublicChadChileChinaChristmas IslandCocos (Килинг) IslandsColombiaComorosCongoCongo, Демократическая Республика TheCook IslandsCosta RicaCote D «ivoireCroatiaCubaCyprusCzech RepublicDenmarkDjiboutiDominicaDominican RepublicEcuadorEgyptEl SalvadorEquatorial GuineaEritreaEstoniaEthiopiaFalkland (Мальвинские) острова Фарерские IslandsFijiFinlandFranceFrench GuianaFrench PolynesiaFrench Южный TerritoriesGabonGambiaGeorgiaGermanyGhanaGibraltarGreeceGreenlandGrenadaGuadeloupeGuamGuatemalaGuernseyGuineaGuinea-bissauGuyanaHaitiHeard остров и МакДональда IslandsHond urasHong Kong (Республика Китай) HungaryIcelandIndiaIndonesiaIran, Исламская Республика OfIraqIrelandIsle Of ManIsraelItalyJamaicaJapanJerseyJordanKazakhstanKenyaKiribatiKorea, Корейской Народно-Демократической Республики OfKorea, Республика OfKuwaitKyrgyzstanLao Народно-Демократической RepublicLatviaLebanonLesothoLiberiaLibyan арабских JamahiriyaLiechtensteinLithuaniaLuxembourgMacaoMacedonia, бывшей югославской Республики OfMadagascarMalawiMalaysiaMaldivesMaliMaltaMarshall IslandsMartiniqueMauritaniaMauritiusMayotteMexicoMicronesia, Федеративные Штаты OfMoldova, Республика OfMonacoMongoliaMontserratMoroccoMozambiqueMyanmarNamibiaNauruNepalNetherlandsNetherlands AntillesNew CaledoniaNew ZealandNicaraguaNigerNigeriaNiueNorfolk IslandNorthern Mariana IslandsNorwayOmanPakistanPalauPalestinian территории, OccupiedPanamaPapua Новая ГвинеяПарагвайПеруФилиппиныПиткэрнПольшаПортугалияПуэрто-РикоКатарВоссоединениеРумынияРоссийская ФедерацияРуандаСент-ЕленаСент-Китс и НевисСент-ЛюсияСент-Пьер и Микелон nadinesSamoaSan MarinoSao Фолиант И PrincipeSaudi ArabiaSenegalSerbia И MontenegroSeychellesSierra LeoneSingaporeSlovakiaSloveniaSolomon IslandsSomaliaSouth AfricaSouth Джорджия и Южные Сандвичевы IslandsSpainSri LankaSudanSurinameSvalbard и Ян MayenSwazilandSwedenSwitzerlandSyrian арабских RepublicTaiwan (Республика Китай) TajikistanTanzania, Объединенная Республика OfThailandTimor-lesteTogoTokelauTongaTrinidad И TobagoTunisiaTurkeyTurkmenistanTurks И Кайкос IslandsTuvaluUgandaUkraineUnited Арабские EmiratesUnited Королевство (Великобритания) Соединенные StatesUnited Штаты Малые отдаленные острова УругвайУзбекистан ВануатуВатикан-государство ВенесуэлаВьетнамВиргинские острова, Британские Виргинские острова, U. s.Wallis And Futuna, Западная Сахара, Йемен, Заир, Замбия, Зимбабве,

s.Wallis And Futuna, Западная Сахара, Йемен, Заир, Замбия, Зимбабве,

Состояние

Почтовый индекс / Почтовый индекс

Отказ от ответственности за доставку: Все заказы подлежат подтверждению. Дополнительные расходы на доставку, хотя и редкие, могут применяться из-за веса, размера, местоположения и / или других переменных. Если для вашего заказа потребуются дополнительные средства для покрытия транспортировки товаров, с вами свяжутся до обработки заказа для утверждения. Светодиодный трансформатор

| Trex | Палубный магазин

Трансформатор Trex LED

Каждый светодиодный трансформатор Trex 12 В постоянного тока включает в себя двухжильный удлинительный кабель LightHub длиной 20 футов, таймер с фотоактивацией и доступен с мощностью 30 Вт 2.5 А 12 В постоянного тока или 100 Вт 8 А 12 постоянного тока версии

- Блок питания Trex, фотоактивируемый таймер, удлинительный кабель с двумя выводами, технология LightHub, 20 футов

- Выходное напряжение: 12 В постоянного тока

- Выходная мощность: 30 Вт 2,5 А, 100 Вт 8,3 А

- Таймер с фотоэлементом

- Отсутствие гарантии на компоненты Trex, если трансформатор Trex не используется

- Поддерживает до 60+ светильников

- 30 Вт: 25DLTRANSFORMER

- 100 Вт: 83DLTRANSFORMER

- В Deck Store есть лицензированные электрики, которые ответят на все ваши вопросы по низковольтному освещению, связанные с продуктами, приобретенными у нас.

- MN Номер лицензии электрика PL-03133

- Всегда используйте источник питания 12 В постоянного тока, чтобы продлить срок службы светодиодов

| Размеры | 2 дюйма x 6,5 дюйма x 1,4 дюйма |

|---|---|

| Размер провода | Двухпроводные отводы с коррекцией полярности с технологией световых концентраторов 5 футов 6 дюймов |

| Мощность | ТрансформаторыTrex 12 В постоянного тока доступны мощностью 30 и 100 Вт | IP68 Водонепроницаемая конструкция |

| Кол-во в упаковке | Одиночный трансформатор Trex, фотоактивированный таймер и 20-футовый удлинительный кабель LightHub |

| Гарантия производителя | Защищено 3-летней ограниченной гарантией |

| Производитель | Trex |

| Справка по установке | http: // s7d4. scene7.com/is/content/Trex/trex-deck-lighting-installation-guidepdf.pdf scene7.com/is/content/Trex/trex-deck-lighting-installation-guidepdf.pdf |

Изображение GPT

Мы обнаружили, что точно так же, как большая модель преобразователя, обученная на языке, может генерировать связный текст, та же самая точная модель, обученная на последовательностях пикселей, может генерировать согласованные дополнения и образцы изображений. Устанавливая корреляцию между качеством выборки и точностью классификации изображений, мы показываем, что наша лучшая генеративная модель также содержит функции, конкурирующие с лучшими сверточными сетями в неконтролируемой настройке.

Содержание

- Введение

- Выполнено

- Образцы

- От языка GPT к образу GPT

- На пути к общему обучению без учителя

- Подход

- Результаты экспериментов

- Ограничения

- Заключение

Введение

Неконтролируемое и самостоятельное обучение, или обучение без данных, помеченных людьми, является давней проблемой машинного обучения. В последнее время он добился невероятных успехов в области языка, поскольку модели преобразователей, такие как BERT, GPT-2, RoBERTa, T5 и другие варианты, достигли максимальной производительности в широком спектре языковых задач. Однако тот же самый широкий класс моделей не смог создать сильных характеристик для классификации изображений. Наша работа направлена на то, чтобы понять и восполнить этот пробел.

В последнее время он добился невероятных успехов в области языка, поскольку модели преобразователей, такие как BERT, GPT-2, RoBERTa, T5 и другие варианты, достигли максимальной производительности в широком спектре языковых задач. Однако тот же самый широкий класс моделей не смог создать сильных характеристик для классификации изображений. Наша работа направлена на то, чтобы понять и восполнить этот пробел.

, такие как BERT и GPT-2, не зависят от предметной области, что означает, что их можно напрямую применять к одномерным последовательностям любой формы.Когда мы обучаем GPT-2 изображениям, развернутым в длинные последовательности пикселей, которые мы называем iGPT, мы обнаруживаем, что модель, похоже, понимает характеристики двухмерного изображения, такие как внешний вид и категория объекта. Об этом свидетельствует широкий спектр образцов когерентного изображения, которые он генерирует, даже без указания ярлыков, предоставленных человеком. В качестве дополнительного доказательства, функции модели обеспечивают высочайшую производительность для ряда наборов классификационных данных и почти самую современную неконтролируемую точность в ImageNet.

| Оценка | Набор данных | Наш результат | Лучший результат без поддержки iGPT |

|---|---|---|---|

| Логистическая регрессия по изученным признакам (линейный зонд) | CIFAR-10 | 96,3 iGPT-L 32×32 с 1536 элементами |

95,3 SimCLR с 8192 функциями |

| CIFAR-100 | 82,8 iGPT-L 32×32 с 1536 элементами |

80.2 SimCLR с 8192 функциями |

|

| STL-10 | 95,5 iGPT-L 32×32 с 1536 элементами |

94,2 AMDIM с 8192 функциями |

|

| ImageNet | 72,0 iGPT-XL a 64×64 с 15360 функциями |

76,5 SimCLR с 8192 функциями |

|

| Полная настройка | CIFAR-10 | 99. |

GPipe, обучен на ImageNet |

| ImageNet 32×32 |

Чтобы подчеркнуть потенциал моделирования генеративной последовательности как универсального алгоритма неконтролируемого обучения, мы намеренно используем ту же архитектуру преобразователя, что и GPT-2 в языке. Как следствие, нам требуется значительно больше вычислений, чтобы создавать функции, конкурентоспособные по сравнению с лучшими неконтролируемыми сверточными сетями.Однако наши результаты показывают, что при столкновении с новой областью, где правильные априорные значения модели неизвестны, большой GPT-2 может изучить отличные функции без необходимости выбора архитектурного дизайна для конкретной области.

Выполнено

Созданные на основе модели доработки полуизображений, предоставленных человеком. Остальные половинки отбираем с температурой 1 и без уловок вроде поиска луча или отбора ядер. В то время как мы демонстрируем наши любимые завершения на первой панели, мы не выбираем изображения или завершения на всех следующих панелях.

В то время как мы демонстрируем наши любимые завершения на первой панели, мы не выбираем изображения или завершения на всех следующих панелях.Созданные на основе модели дополнения полуизображений, созданных человеком. Остальные половинки отбираем с температурой 1 и без уловок вроде поиска луча или отбора ядер. В то время как мы демонстрируем наши любимые завершения на первой панели, мы не выбираем изображения или завершения на всех следующих панелях.

Образцы

Образцы изображений, созданных на основе модели. Мы делаем выборку этих изображений с температурой 1 и без уловок вроде поиска луча или выборки ядра. Показаны все наши образцы, без сбора вишен.Почти все сгенерированные изображения содержат четко узнаваемые объекты. Образцы изображений, созданных на основе модели. Мы делаем выборку этих изображений с температурой 1 и без уловок вроде поиска луча или выборки ядра. Показаны все наши образцы, без сбора вишен. Почти все сгенерированные изображения содержат четко узнаваемые объекты.

От языка GPT к образу GPT

В области языка алгоритмы неконтролируемого обучения, основанные на предсказании слов (например, GPT-2 и BERT), оказались чрезвычайно успешными, достигнув максимальной производительности в широком спектре языковых задач.Одна из возможных причин этого успеха заключается в том, что экземпляры последующих языковых задач естественным образом появляются в тексте: вопросы часто сопровождаются ответами (которые могут помочь с ответами на вопросы), а отрывки часто сопровождаются резюме (которые могут помочь в резюмировании). Напротив, последовательности пикселей явно не содержат меток для изображений, которым они принадлежат.

Даже без этого явного контроля все еще есть причина, по которой GPT-2 на изображениях может работать: достаточно большой преобразователь, обученный предсказанию следующего пикселя, может в конечном итоге научиться генерировать различные образцы с четко распознаваемыми объектами.Как только модель научится это делать, идея, известная как «Анализ путем синтеза», предполагает, что модель также будет знать о категориях объектов. Многие ранние генеративные модели были мотивированы этой идеей, и совсем недавно BigBiGAN был примером, который произвел обнадеживающие образцы и функции. В своей работе мы сначала показываем, что лучшие генеративные модели обеспечивают более высокую эффективность классификации. Затем, оптимизируя GPT-2 для генеративных возможностей, мы достигаем производительности классификации верхнего уровня во многих условиях, предоставляя дополнительные доказательства для анализа путем синтеза.

Многие ранние генеративные модели были мотивированы этой идеей, и совсем недавно BigBiGAN был примером, который произвел обнадеживающие образцы и функции. В своей работе мы сначала показываем, что лучшие генеративные модели обеспечивают более высокую эффективность классификации. Затем, оптимизируя GPT-2 для генеративных возможностей, мы достигаем производительности классификации верхнего уровня во многих условиях, предоставляя дополнительные доказательства для анализа путем синтеза.

На пути к общему обучению без учителя

Моделирование генеративной последовательности — это универсальный алгоритм обучения без учителя: поскольку все типы данных могут быть представлены как последовательности байтов, преобразователь может быть напрямую применен к любому типу данных без дополнительной инженерии. Наша работа проверяет силу этой универсальности, напрямую применяя архитектуру, используемую для обучения GPT-2 на естественном языке, для создания изображений. Мы сознательно отказались от ручного кодирования каких-либо знаний, связанных с изображением, в форме сверток или техник, таких как относительное внимание, рассеянное внимание и встраивание двухмерных позиций.

Вследствие его универсальности, наш метод требует значительно больше вычислительных ресурсов для достижения конкурентоспособной производительности в неконтролируемой среде. Действительно, контрастные методы по-прежнему являются наиболее эффективными с вычислительной точки зрения методами для создания высококачественных элементов из изображений. Однако, показывая, что модель неконтролируемого преобразователя конкурентоспособна с лучшими неконтролируемыми сверточными сетями, мы предоставляем доказательства того, что можно обменять знания предметной области, кодированные вручную, на вычисления.В новых областях, где не так много знаний в коде, масштабирование вычислений кажется подходящим методом для тестирования.

Подход

Мы обучаем iGPT-S, iGPT-M и iGPT-L, трансформаторы, содержащие параметры 76M, 455M и 1.4B соответственно, в ImageNet. Мы также обучаем iGPT-XL, преобразователь 6,8 миллиардов параметров, на сочетании ImageNet и изображений из Интернета. Из-за больших вычислительных затрат на моделирование длинных последовательностей с повышенным вниманием, мы тренируемся с низкими разрешениями 32×32, 48×48 и 64×64.

Хотя заманчиво работать с еще более низкими разрешениями для дальнейшего снижения затрат на вычисления, предыдущие исследования показали, что производительность человека при классификации изображений начинает быстро падать ниже этих размеров. Вместо этого, руководствуясь ранними цветовыми палитрами отображения, мы создаем нашу собственную 9-битную цветовую палитру для представления пикселей. Использование этой палитры дает длину входной последовательности в 3 раза короче стандартной (R, G, B) палитры, при этом все еще точно кодирует цвет.

Результаты экспериментов

Есть два метода, которые мы используем для оценки производительности модели, каждый из которых включает задачу последующей классификации.Первый, который мы называем линейным зондом, использует обученную модель для извлечения функций из изображений в последующем наборе данных, а затем подгоняет логистическую регрессию к меткам. Второй метод точно настраивает всю модель в последующем наборе данных.

Поскольку предсказание следующего пикселя явно не имеет отношения к классификации изображений, признаки из последнего слоя могут не быть наиболее предсказуемыми для категории объекта. Наш первый результат показывает, что качество элементов резко возрастает, а затем слегка уменьшается от глубины.Такое поведение предполагает, что генеративная модель преобразователя работает в два этапа: на первом этапе каждая позиция собирает информацию из своего окружающего контекста, чтобы построить контекстуализированную функцию изображения. На втором этапе эта контекстуализированная функция используется для решения задачи условного прогнозирования следующего пикселя. Наблюдаемые двухэтапные характеристики наших линейных датчиков напоминают другую неконтролируемую нейронную сеть, автокодировщик узких мест, который спроектирован вручную таким образом, что используются функции в середине.

Качество элемента во многом зависит от слоя, который мы выбираем для оценки. В отличие от моделей с учителем, лучшие функции этих генеративных моделей находятся в середине сети.

Наш следующий результат устанавливает связь между производительностью генерации и качеством функций. Мы обнаружили, что как увеличение масштаба наших моделей, так и обучение для большего количества итераций приводят к лучшей генеративной производительности, что напрямую влияет на лучшее качество функций.

Наведите курсор, чтобы увидеть образцы изображений вверх

Каждая линия отслеживает модель на протяжении генеративного предварительного обучения: пунктирные маркеры обозначают контрольные точки на этапах 131K, 262K, 524K и 1000K.Положительные наклоны предполагают связь между улучшенной производительностью генерации и улучшением качества функций. Более крупные модели также обладают лучшими характеристиками, чем модели меньшего размера. iGPT-XL не включен, потому что он был обучен на другом наборе данных.

Когда мы оцениваем наши функции с помощью линейных датчиков на CIFAR-10, CIFAR-100 и STL-10, мы опережаем возможности всех контролируемых и неконтролируемых алгоритмов передачи. Наши результаты также убедительны при полной настройке.

| Предварительное обучение в ImageNet | ||||

|---|---|---|---|---|

| Оценка | Модель | Точность | без этикеток | с этикетками |

| CIFAR-10 Линейный датчик |

ResNet-152 | 94.0 | проверить | |

| SimCLR | 95,3 | проверить | ||

| iGPT-L 32×32 | 96,3 | проверить | ||

| CIFAR-100 Линейный датчик |

ResNet-152 | 78,0 | проверить | |

| SimCLR | 80,2 | проверить | ||

| iGPT-L 32×32 | 82.8 | проверить | ||

| STL-10 Линейный датчик |

AMDIM-L | 94,2 | проверить | |

| iGPT-L 32×32 | 95,5 | проверить | ||

| CIFAR-10 Точная настройка |

AutoAugment | 98,5 | ||

| SimCLR | 98,6 | проверить | ||

| GPipe | 99.0 | проверить | ||

| iGPT-L | 99,0 | проверить | ||

| CIFAR-100 Точная настройка |

iGPT-L | 88,5 | проверить | |

| SimCLR | 89,0 | проверить | ||

| AutoAugment | 89,3 | |||

| EfficientNet | 91.7 | проверить | ||

Сравнение точности линейного датчика и точной настройки между нашими моделями и высокопроизводительными моделями, которые используют неконтролируемую или контролируемую передачу данных ImageNet. Мы также включаем AutoAugment, самую эффективную модель, полностью обученную на CIFAR.

Учитывая возрождение интереса к неконтролируемому и самостоятельному обучению в ImageNet, мы также оцениваем производительность наших моделей, используя линейные датчики в ImageNet.Это особенно сложная настройка, поскольку мы не тренируемся при стандартном входном разрешении ImageNet. Тем не менее, линейный зонд на 1536 объектах из лучшего слоя iGPT-L, обученный на изображениях 48×48, дает точность 65,2%, превосходя AlexNet.

Контрастные методы обычно сообщают о своих лучших результатах по 8192 функциям, поэтому в идеале мы бы оценили iGPT с размером встраивания 8192 для сравнения. Однако обучение такой модели непомерно дорого, поэтому мы вместо этого объединяем функции из нескольких слоев в качестве приближения.К сожалению, наши функции, как правило, коррелируют по уровням, поэтому нам нужно их больше, чтобы быть конкурентоспособными. Использование 15360 функций из 5 уровней в iGPT-XL дает 72,0% точности, превосходя AMDIM, MoCo и CPC v2, но все же уступая SimCLR с приличным отрывом.

| Метод | Входное разрешение | Характеристики | Параметры | Точность |

|---|---|---|---|---|

| Вращение | оригинал | 8192 | 86M | 55.4 |

| iGPT-L | 32×32 | 1536 | 1362M | 60,3 |

| BigBiGAN | оригинал | 16384 | 86M | 61,3 |

| iGPT-L | 48×48 | 1536 | 1362M | 65,2 |

| AMDIM | оригинал | 8192 | 626M | 68.1 |

| MoCo | оригинал | 8192 | 375M | 68,6 |

| iGPT-XL | 64×64 | 3072 | 6801M | 68,7 |

| SimCLR | оригинал | 2048 | 24M | 69,3 |

| CPC v2 | оригинал | 4096 | 303M | 71.5 |

| iGPT-XL | 64×64 | 3072 х 5 | 6801M | 72,0 |

| SimCLR | оригинал | 8192 | 375M | 76,5 |

Сравнение точности линейных датчиков наших моделей и современных моделей с самоконтролем. Мы достигаем конкурентоспособных результатов при обучении с гораздо более низким входным разрешением, хотя наш метод требует большего количества параметров и вычислений.

Поскольку модели языка с масками, такие как BERT, превзошли генеративные модели в большинстве языковых задач, мы также оцениваем производительность BERT на наших моделях изображений. Вместо того, чтобы обучать нашу модель предсказанию следующего пикселя с учетом всех предыдущих пикселей, мы маскируем 15% пикселей и обучаем нашу модель предсказывать их на основе немаскированных. Мы обнаружили, что, хотя характеристики линейных пробников на моделях BERT значительно хуже, они превосходны во время точной настройки:

CIFAR-10

ImageNet

Сравнение генеративного предварительного обучения с предварительным обучением BERT с использованием iGPT-L при входном разрешении 32 2 × 3.Жирные цвета показывают повышение производительности за счет ансамбля масок BERT. Мы видим, что генеративные модели после предварительного обучения дают гораздо лучшие характеристики, чем модели BERT, но модели BERT догоняют после точной настройки.

В то время как неконтролируемое обучение обещает отличные возможности без необходимости в данных, помеченных людьми, в последнее время был достигнут значительный прогресс в рамках более щадящей структуры полууправляемого обучения, которая допускает ограниченные объемы данных, помеченных человеком. Успешные полууправляемые методы часто основываются на умных методах, таких как регуляризация согласованности, увеличение данных или псевдо-маркировка, а чисто генеративные подходы не были конкурентоспособными в течение многих лет.Мы оцениваем iGPT-L на конкурентном тесте для этого подполя и обнаруживаем, что простой линейный анализ функций из нерасширенных изображений превосходит Mean Teacher и MixMatch, хотя и уступает FixMatch.

| Модель | 40 этикеток | 250 этикеток | 4000 этикеток |

|---|---|---|---|

| Улучшенный GAN | – | – | 81,4 ± 2,3 |

| Средний учитель | – | 67.7 ± 2,3 | 90,8 ± 0,2 |

| MixMatch | 52,5 ± 11,5 | 89,0 ± 0,9 | 93,6 ± 0,1 |

| iGPT-L | 73,2 ± 01,5 | 87,6 ± 0,6 | 94,3 ± 0,1 |

| УДА | 71,0 ± 05,9 | 91,2 ± 1,1 | 95,1 ± 0,2 |

| FixMatch RA | 86,2 ± 03,4 | 94.9 ± 0,7 | 95,7 ± 0,1 |

| FixMatch CTA | 88,6 ± 03,4 | 94,9 ± 0,3 | 95,7 ± 0,2 |

Сравнение производительности на CIFAR-10 с низким объемом данных. Используя множество немаркированных изображений ImageNet, iGPT-L может превзойти такие методы, как Mean Teacher и MixMatch, но по-прежнему уступает современным методам. Наш подход к полу-контролируемому обучению очень прост, поскольку мы подбираем классификатор логистической регрессии только для функций iGPT-L без какого-либо дополнения или тонкой настройки данных — существенное отличие от специально разработанных полу-контролируемых подходов.

Ограничения

Хотя мы показали, что iGPT способен изучать мощные функции изображений, наш подход все же имеет существенные ограничения. Поскольку мы используем общий преобразователь последовательности, используемый для GPT-2 на языке, наш метод требует большого объема вычислений: iGPT-L был обучен примерно за 2500 V100-дней, в то время как аналогичная модель MoCo может быть обучена примерно за 70 V100-дней.

Соответственно, мы моделируем входы с низким разрешением с помощью трансформатора, в то время как большинство результатов с самоконтролем используют сверточные кодеры, которые могут легко потреблять входные данные с высоким разрешением.Для дальнейшего масштабирования может потребоваться новая архитектура, например, многомасштабный преобразователь, не зависящий от предметной области. Учитывая эти ограничения, наша работа в первую очередь служит доказательной демонстрацией способности больших языковых моделей, основанных на преобразователях, изучать отличные неконтролируемые представления в новых предметных областях без необходимости в жестко закодированных знаниях предметной области. Однако значительные затраты ресурсов на обучение этих моделей и более высокая точность методов на основе сверточных нейронных сетей исключают эти представления из практических приложений реального мира в области видения.